Fingers$Height2Group <- ntile(Fingers$Height, 2)

head(select(Fingers, Thumb, Height, Height2Group), 10)9 Κεφάλαιο: Εμβαθύνοντας στα Mοντέλα Oμάδων

Όλα πρέπει να γίνονται όσο πιο απλά είναι δυνατόν, αλλά όχι απλούστερα.

— Albert Einstein

9.1 Επέκταση σε Μοντέλο Τριών Ομάδων

Μέχρι αυτό το σημείο έχετε μάθει πώς να ορίζετε ένα μοντέλο με μία ανεξάρτητη ποιοτική μεταβλητή που περιλαμβάνει δύο κατηγορίες (ομάδες). Η επέκταση αυτής της ιδέας σε μια ποιοτική ανεξάρτητη μεταβλητή με τρεις ομάδες είναι σχετικά απλή.

Ένα Νέο Μοντέλο Δύο Ομάδων

Ας χρησιμοποιήσουμε μια νέα ανεξάρτητη μεταβλητή για να εξηγήσουμε τη μεταβλητότητα στο μήκος του αντίχειρα: το Ύψος φοιτητή (Height). Στο πλαίσιο δεδομένων Fingers, το ύψος είναι μια ποσοτική μεταβλητή μετρημένη σε εκατοστά. Για εκπαιδευτικούς σκοπούς, μπορούμε να δημιουργήσουμε μια νέα μεταβλητή που μετατρέπει το ύψος σε ποιοτική μεταβλητή με δύο κατηγορίες: short (κοντοί) και tall (ψηλοί).

Μπορούμε να το επιτύχουμε αυτό με τη συνάρτηση ntile(). Ο παρακάτω κώδικας χωρίζει το δείγμα σε δύο ομάδες ίσου μεγέθους με βάση το ύψος (Height) και αποθηκεύει το αποτέλεσμα σε μια νέα μεταβλητή με το όνομα Height2Group.

Χρησιμοποιήσαμε τις συναρτήσεις head() και select() για να εμφανίσουμε τις πρώτες 10 γραμμές των σχετικών μεταβλητών: Thumb, Height και Height2Group:

Thumb Height Height2Group

1 66.00 179.070 2

2 64.00 164.592 1

3 56.00 162.560 1

4 58.42 177.800 2

5 74.00 172.720 2

6 60.00 172.720 2

7 70.00 175.260 2

8 55.00 166.878 2

9 60.00 158.750 1

10 52.00 161.036 1Στο παρακάτω πλαίσιο κώδικα, χρησιμοποιήστε τη συνάρτηση factor() για να προσθέσετε ετικέτες στη μεταβλητή Height2Group, ώστε η τιμή 1 να αντιστοιχεί στο short και η τιμή 2 στο tall:

Thumb Height Height2Group

1 66.00 179.070 tall

2 64.00 164.592 short

3 56.00 162.560 short

4 58.42 177.800 tall

5 74.00 172.720 tall

6 60.00 172.720 tall

7 70.00 175.260 tall

8 55.00 166.878 tall

9 60.00 158.750 short

10 52.00 161.036 shortΑκολουθούμε την ίδια προσέγγιση που ακολουθήσαμε για τη μεταβλητή Gender και γράφουμε το μοντέλο της Height2Group ως εξής:

\[\text{Thumb}_i = b_0 + b_1 \text{Height2Group}_i + e_i\]

Τι σημαίνουν τα διαφορετικά σύμβολα στην παραπάνω εξίσωση;

Το \(Y_i\) αντιστοιχεί σε:

Το \(X_i\) αντιστοιχεί σε:

Η γενική μορφή του μοντέλου:

\[Y_i = b_0 + b_1X_i + e_i\]

Στο συγκεκριμένο μοντέλο:

\[\text{Thumb}_i = b_0 + b_1\text{Height2Group}_i + e_i\]

\(Y_i\) = Thumb (Εξαρτημένη μεταβλητή)

Το \(Y_i\) είναι η εξαρτημένη μεταβλητή

Αυτό που προσπαθούμε να προβλέψουμε ή να εξηγήσουμε

Σε αυτήν την περίπτωση: το μήκος του αντίχειρα

\(X_i\) = Height2Group (Ανεξάρτητη μεταβλητή)

Το \(X_i\) είναι η ανεξάρτητη μεταβλητή

Αυτό που χρησιμοποιούμε για να εξηγήσουμε τη μεταβλητότητα στην \(Y\)

Σε αυτήν την περίπτωση: η ομάδα του ύψους (1 = short, 2 = tall)

Άλλα σύμβολα:

\(b_0\): μέσος όρος της ομάδας αναφοράς

\(b_1\): μέση διαφορά μεταξύ των ομάδων

\(e_i\): υπόλοιπο (σφάλμα πρόβλεψης)

\(i\): δείκτης για κάθε παρατήρηση (κάθε άτομο)

Γιατί όχι οι άλλες:

Height: Δεν χρησιμοποιείται στο μοντέλο (χρησιμοποιείται η Height2Group)Gender: Δεν εμφανίζεται στο μοντέλοshort/tall: Αυτές είναι οι τιμές τηςHeight2Group, όχι η μεταβλητή

Μπορείτε να προσαρμόσετε το μοντέλο με τη συνάρτηση lm() και να εμφανίσετε τις εκτιμήσεις των παραμέτρων και τον πίνακα ANOVA:

lm(formula = Thumb ~ Height2Group, data = Fingers)

Coefficients:

(Intercept) Height2Grouptall

57.818 4.601 Η τιμή του \(b_0\) είναι:

Η τιμή του \(b_1\) είναι:

Από τα αποτελέσματα της lm():

\(b_0\) = 57.818 (

Intercept)\(b_1\) = 4.601 (

Height2Grouptall)

Το μοντέλο:

\[\text{Thumb}_i = 57.818 + 4.601 \times \text{Height2Group}_i\]

Ερμηνεία:

\(b_0 = 57.818\) mm:

Ο μέσος όρος του μήκους αντίχειρα για την ομάδα αναφοράς (short)

Όταν Height2Group = 0 (short)

\(b_1 = 4.601\) mm:

Η διαφορά στο μέσο μήκος αντίχειρα μεταξύ tall και short

Τα ψηλά άτομα έχουν κατά μέσο όρο 4.601mm μεγαλύτερο αντίχειρα

Υπολογισμοί:

Γιατί στα αποτελέσματα εμφανίζεται το όνομα Height2Grouptall (αντί απλά το Height2Group);

Πώς θα γίνει από την lm η κωδικοποίηση της \(X_i\) για να έχει νόημα αυτό το μοντέλο;

Πρώτη ερώτηση - Σωστή απάντηση: Δ

Γιατί Height2Grouptall:

Η R προσθέτει το όνομα της κατηγορίας στο όνομα της μεταβλητής για να δείξει ποιο επίπεδο κωδικοποιείται ως 1.

# Η μεταβλητή: Height2Group

# Οι κατηγορίες (levels): "short" και "tall"

# Ομάδα αναφοράς: "short" (κωδικοποιείται ως 0)

# Ομάδα σύγκρισης: "tall" (κωδικοποιείται ως 1)

# Άρα ο συντελεστής ονομάζεται: Height2GrouptallΕρμηνεία του \(b_1 = 4.601\):

Αυτή είναι η ποσότητα που προστίθεται στο μήκος αντίχειρα όταν κάποιος είναι στην ομάδα tall.

# Short: Thumb = 57.818 + 4.601×0 = 57.818 mm

# Tall: Thumb = 57.818 + 4.601×1 = 62.419 mm

# Η ποσότητα που προστίθεται: +4.601mm για tallΔεύτερη ερώτηση - Σωστή απάντηση: Δ

Κωδικοποίηση 0/1 (dummy coding):

Γιατί 0/1:

Αυτή είναι η προεπιλεγμένη κωδικοποίηση στην lm() για ποσοτικές μεταβλητές:

\[\text{Thumb} = 57.818 + 4.601 \times X_i\]

Όταν \(X_i = 0\) (

short):Thumb= 57.818 ✓Όταν \(X_i = 1\) (

tall):Thumb= 57.818 + 4.601 = 62.419 ✓

Γιατί οι άλλες είναι λάθος:

Α & Γ (-1/1): Αυτή η κωδικοποίηση ονομάζεται κωδικοποίηση επίδρασης (effect coding)

Θα έδινε διαφορετικές εκτιμήσεις

Το

Interceptθα ήταν ο γενικός μέσος όρος, όχι ο μέσος όρος τηςshort

Β (1/2):

Δεν χρησιμοποιείται

Θα έδινε λάθος ερμηνεία του

Intercept

Συμπέρασμα:

Η lm() χρησιμοποιεί ψευδομεταβλητή (0/1) όπου:

0 = ομάδα αναφοράς (

short)1 = ομάδα σύγκρισης (

tall)Το όνομα

Height2Grouptallδείχνει ότι ο συντελεστής αναφέρεται στην κατηγορίαtall

Analysis of Variance Table (Type III SS)

Model: Thumb ~ Height2Group

SS df MS F PRE p

----- --------------- | --------- --- ------- ------ ------ -----

Model (error reduced) | 830.880 1 830.880 11.656 0.0699 .0008

Error (from model) | 11049.331 155 71.286

----- --------------- | --------- --- ------- ------ ------ -----

Total (empty model) | 11880.211 156 76.155Τι είναι το SS Total; (Υπάρχουν περισσότερες από μία σωστές απαντήσεις.)

Σωστές απαντήσεις: Α, Β, Δ

Το SS\(_{\text{Total}}\) είναι το ίδιο με το SS\(_{\text{Error}}\) από το κενό μοντέλο.

Α. Συνολικό τετραγωνικό σφάλμα από το γενικό μέσο όρο - ΣΩΣΤΟ ✓

\[\text{SS}_{\text{Total}} = \sum_{i=1}^{n}(\text{Thumb}_i - \bar{\text{Thumb}})^2\]

Μετράει όλη τη μεταβλητότητα στα δεδομένα

Υπόλοιπα από το γενικό μέσο όρο (κενό μοντέλο)

Β. Το άθροισμα τετραγώνων των υπολοίπων από το κενό μοντέλο - ΣΩΣΤΟ ✓

Το κενό μοντέλο προβλέπει μόνο το γενικό μέσο όρο

Όλη η μεταβλητότητα είναι “σφάλμα” σε αυτό το μοντέλο

Δ. Το άθροισμα τετραγώνων των σφαλμάτων από το κενό μοντέλο - ΣΩΣΤΟ ✓

Αυτό είναι ακριβώς το ίδιο με το Β

SS Total = SS Error (από το κενό μοντέλο)

Γιατί οι άλλες είναι λάθος:

Γ. “Εξηγείται από Height2Group” - ΛΑΘΟΣ:

Αυτό είναι το SS Model (830.880), όχι το SS Total

SS Model = η μεταβλητότητα που εξηγείται

Σχέση:

\[\text{SS}_{\text{Total}} = \text{SS}_{\text{Model}} + \text{SS}_{\text{Error}}\]

\[11880.211 = 830.880 + 11049.331\]

Συμπέρασμα:

Το SS\(_{\text{Total}}\) (11880.211) αντιπροσωπεύει:

Τη συνολική μεταβλητότητα στο μήκος αντίχειρα

Το σφάλμα (ή τη μεταβλητότητα που υπολείπεται) από το κενό μοντέλο

Το άθροισμα τετραγώνων των αποκλίσεων από το γενικό μέσο όρο

Ποια είναι η τιμή του PRE για το μοντέλο της

Height2Group;

Τι δείχνει ο δείκτης PRE;

Σωστή απάντηση: Γ

PRE = Αναλογική Μείωση του Σφάλματος (Proportional Reduction in Error)

\[\text{PRE} = \frac{\text{SS}_{\text{Model}}}{\text{SS}_{\text{Total}}} = \frac{830.880}{11880.211} = 0.0699\]

Ερμηνεία:

Το PRE = 0.0699 (ή 6.99%) σημαίνει ότι το μοντέλο της Height2Group εξηγεί περίπου το 7% της μεταβλητότητας του μήκους αντίχειρα.

Γιατί οι άλλες είναι λάθος:

Α. “Εξηγείται από το κενό μοντέλο” - ΛΑΘΟΣ:

Το κενό μοντέλο δεν εξηγεί μεταβλητότητα

Το PRE πάντα αναφέρεται στο σύνθετο μοντέλο

Β. “Αριθμός τετραγωνικών mm” - ΛΑΘΟΣ:

Αυτό θα ήταν το

SS Model(830.880mm²)Το PRE είναι αναλογία (0-1), όχι απόλυτη τιμή

Δ. “Ανεξήγητη μεταβλητότητα” - ΛΑΘΟΣ:

Αυτό θα ήταν: \(1 - \text{PRE} = 1 - 0.0699 = 0.9301\) (93%)

Το PRE μετράει την εξηγούμενη, όχι την ανεξήγητη

Ε. “Άθροισμα σφαλμάτων” - ΛΑΘΟΣ:

Παράδοξο: τα σφάλματα δεν “εξηγούνται”

Το μοντέλο μειώνει το σφάλμα εξηγώντας μεταβλητότητα

Συμπέρασμα:

Το PRE είναι η αναλογία της μεταβλητότητας που εξηγείται από το μοντέλο της Height2Group - ένας δείκτης χωρίς μονάδες μέτρησης μεταξύ του 0 και του 1 που δείχνει πόσο καλά το μοντέλο εξηγεί τη μεταβλητότητα στα δεδομένα.

Ένα Μοντέλο Τριών Ομάδων

Ας εφαρμόσουμε τώρα την ίδια προσέγγιση, αυτή τη φορά χωρίζοντας το δείγμα σε τρεις ομάδες ύψους: short, medium και tall.

Τροποποιήστε τον παρακάτω κώδικα ώστε να δημιουργηθεί μια νέα μεταβλητή με όνομα Height3Group, η οποία θα ταξινομεί τους φοιτητές σε τρεις κατηγορίες με βάση το ύψος τους, καθεμία με ίσο αριθμό ατόμων. Κωδικοποιήστε τις κατηγορίες (1, 2, 3) ως short, medium και tall, αντίστοιχα.

Thumb Height Height3Group

1 66.00 179.070 tall

2 64.00 164.592 medium

3 56.00 162.560 short

4 58.42 177.800 tall

5 74.00 172.720 tall

6 60.00 172.720 tall

7 70.00 175.260 tall

8 55.00 166.878 medium

9 60.00 158.750 short

10 52.00 161.036 shortΥπολογίστε και εμφανίστε τους μέσους όρους για τις τρεις ομάδες ύψους.

Height3Group min Q1 median Q3 max mean sd n missing

1 short 39.00 51.00 55 58.42 79.00 56.07113 7.499937 53 0

2 medium 45.00 55.00 60 64.00 86.36 60.22375 8.490406 52 0

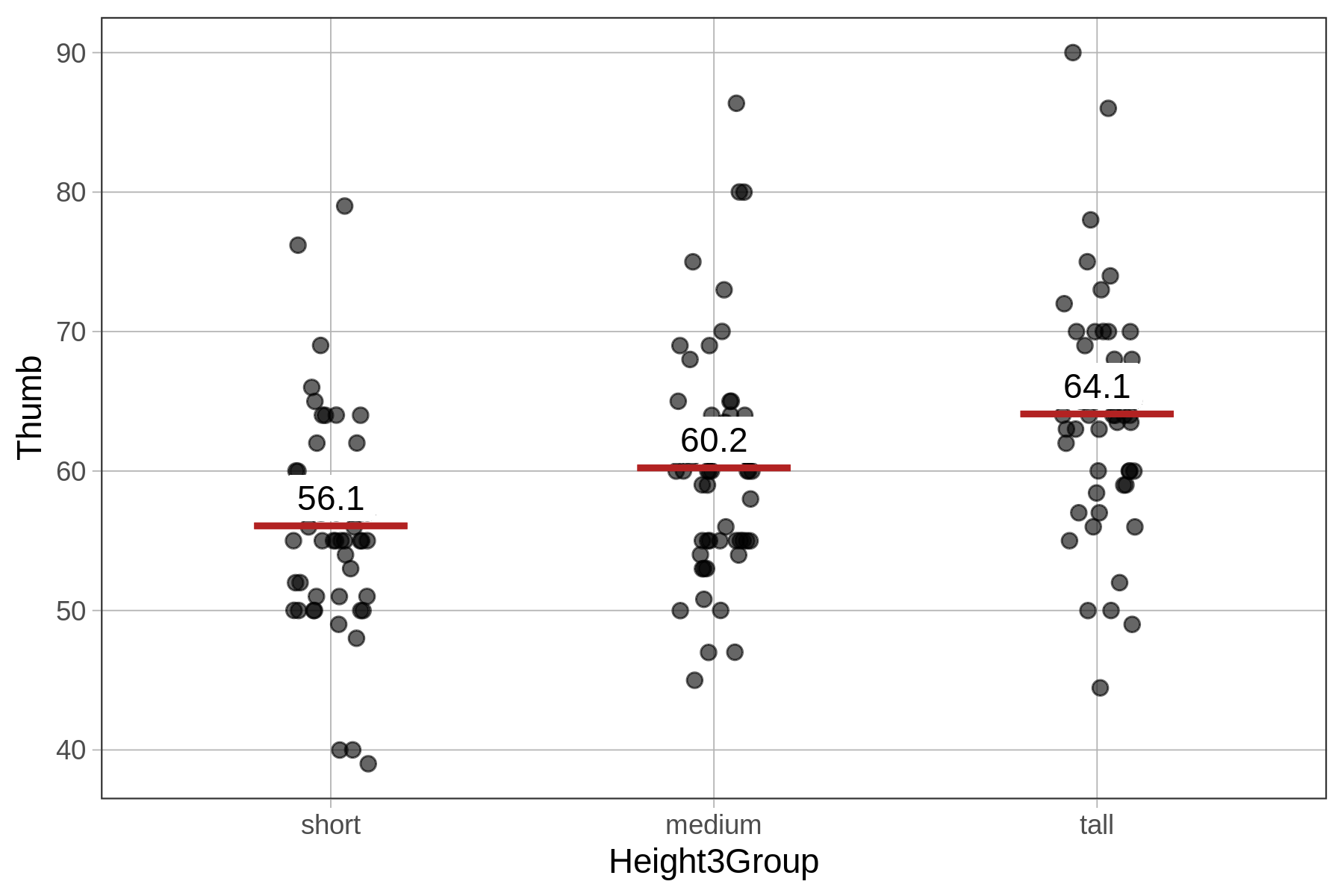

3 tall 44.45 59.75 64 68.25 90.00 64.09365 8.388113 52 0Ποιο μοτίβο παρατηρείτε στους μέσους όρους, σύμφωνα με τα αποτελέσματα της favstats(), για τις τρεις ομάδες της μεταβλητής Height3Group;

Σωστή απάντηση: Γ

Το μοτίβο των μέσων:

short: mean = 56.07 mm

medium: mean = 60.22 mm

tall: mean = 64.09 mm

# Ξεκάθαρη αύξηση: 56 → 60 → 64Καθώς το ύψος αυξάνεται, ο μέσος όρος του μήκους αντίχειρα επίσης αυξάνεται.

Γιατί οι άλλες είναι λάθος:

Α. “Περισσότεροι άνθρωποι” - ΛΑΘΟΣ:

Το n είναι παρόμοιο: 53, 52, 52

Όχι σαφές μοτίβο αύξησης

Η ερώτηση είναι για το μοτίβο των μέσων, όχι των μεγεθών δείγματος

Β. “Ψηλότεροι άνθρωποι στην tall” - ΛΑΘΟΣ:

Αυτός ο πίνακας δείχνει μήκος αντίχειρα (Thumb), όχι ύψος ατόμου

Οι ομάδες ορίζονται από ύψος, αλλά τα δεδομένα είναι για αντίχειρες

Η δήλωση είναι τετριμμένη (προφανώς η ομάδα “tall” έχει ψηλότερα άτομα)

Δ. “Medium > tall” - ΛΑΘΟΣ:

Το αντίθετο είναι αληθές

medium: 60.22 mm < tall: 64.09 mm

Συμπέρασμα:

Υπάρχει μια θετική συνάφεια μεταξύ ύψους και μήκους αντίχειρα: οι ψηλότερες ομάδες έχουν κατά μέσο όρο μεγαλύτερους αντίχειρες.

Ακολουθεί ένα διάγραμμα jitter που απεικονίζει την κατανομή του μήκους αντίχειρα για κάθε μία από τις τρεις ομάδες ύψους, μαζί με το μέσο όρο κάθε ομάδας. Στην επόμενη ενότητα θα δούμε πώς να προσαρμόσουμε ένα μοντέλο μήκους αντίχειρα βασισμένο στις τρεις αυτές ομάδες.

9.2 Προσαρμογή και Ερμηνεία του Μοντέλου Τριών Ομάδων

Τώρα μπορούμε να δημιουργήσουμε ένα μοντέλο που προσαρμόζει τις προβλέψεις ανάλογα με το αν οι φοιτητές είναι κοντοί, μετρίου ύψους ή ψηλοί (δηλαδή, με βάση τη μεταβλητή Height3Group). Ας δούμε πώς να προσαρμόσουμε αυτό το μοντέλο με την R και τη σημειολογία του GLM.

Προσαρμογή του Μοντέλου της Height3Group

Χρησιμοποιήστε τον παρακάτω κώδικα για να προσαρμόσετε το μοντέλο στα δεδομένα και να εμφανίσετε τις εκτιμήσεις των παραμέτρων:

lm(formula = Thumb ~ Height3Group, data = Fingers)

Coefficients:

(Intercept) Height3Groupmedium Height3Grouptall

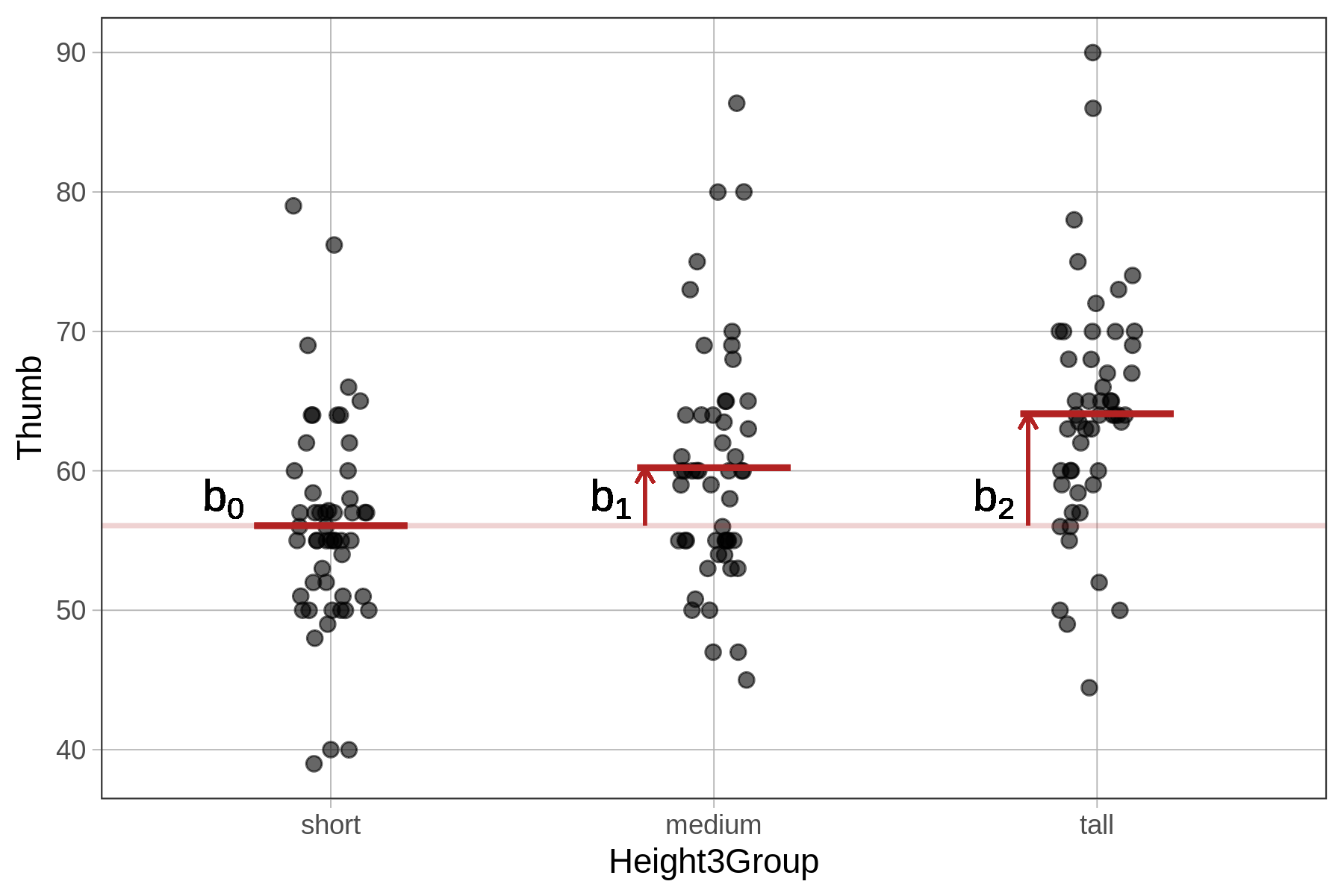

56.071 4.153 8.023Το μοντέλο τριών ομάδων μπορεί να εκφραστεί με τη σημειολογία του Γενικού Γραμμικού Μοντέλου (GLM) ως εξής:

\[Y_i = b_0 + b_1 X_{1i} + b_2 X_{2i} + e_i\]

Ενώ η προσαρμογή του μοντέλου δύο ομάδων περιλάμβανε δύο εκτιμήσεις παραμέτρων (\(b_0\) και \(b_1\)), το μοντέλο τριών ομάδων προσθέτει μια τρίτη (\(b_2\)), η οποία αντιστοιχεί στη διαφορά του μέσου όρου της τρίτης ομάδας σε σχέση με την ομάδα αναφοράς.

Ποιοι αριθμοί από το μοντέλο της Height3Group αντιστοιχούν σε αυτές τις εκτιμήσεις παραμέτρων;

\(b_0\) =

\(b_1\) =

\(b_2\) =

Από τα αποτελέσματα της lm():

\(b_0\) = 56.071 (Intercept)

\(b_1\) = 4.153 (Height3Groupmedium)

\(b_2\) = 8.023 (Height3Grouptall)

Το μοντέλο:

\[\text{Thumb}_i = 56.071 + 4.153 \times X_{1i} + 8.023 \times X_{2i}\]

όπου:

\(X_{1i}\) = 1 αν medium, 0 διαφορετικά

\(X_{2i}\) = 1 αν tall, 0 διαφορετικά

Ερμηνεία:

\(b_0 = 56.071\) mm:

Ο μέσος όρος του μήκους αντίχειρα για την ομάδα αναφοράς (short)

Όταν \(X_1 = 0\) και \(X_2 = 0\) (short)

\(b_1 = 4.153\) mm:

Η ποσότητα που προστίθεται για την ομάδα medium

Η διαφορά μεταξύ medium και short

\(b_2 = 8.023\) mm:

Η ποσότητα που προστίθεται για την ομάδα tall

Η διαφορά μεταξύ tall και short

Υπολογισμοί των μέσων όρων:

# Short group (X1 = 0, X2 = 0):

Thumb = 56.071 + 4.153×0 + 8.023×0 = 56.071mm

# Medium group (X1 = 1, X2 = 0):

Thumb = 56.071 + 4.153×1 + 8.023×0 = 60.224mm

# Tall group (X1 = 0, X2 = 1):

Thumb = 56.071 + 4.153×0 + 8.023×1 = 64.094mmΠαρατήρηση:

Αυτές οι τιμές ταιριάζουν με τους μέσους όρους από την favstats():

short: 56.07mm ✓

medium: 60.22mm ✓

tall: 64.09mm ✓

Το \(Y_i\) αντιστοιχεί σε:

Το \(X_{1i}\) αντιστοιχεί σε:

Το \(X_{2i}\) αντιστοιχεί σε:

Το μοντέλο τριών ομάδων:

\[Y_i = b_0 + b_1X_{1i} + b_2X_{2i} + e_i\]

Για το συγκεκριμένο μοντέλο:

\[\text{Thumb}_i = 56.071 + 4.153X_{1i} + 8.023X_{2i} + e_i\]

\(Y_i\) = Το μήκος του αντίχειρα του ατόμου

Η εξαρτημένη μεταβλητή

Αυτό που προσπαθούμε να προβλέψουμε

Μετριέται σε χιλιοστά (mm)

\(X_{1i}\) = Αν το άτομο ανήκει στην ομάδα medium

Ψευδομεταβλητή (dummy variable) για την ομάδα

medium\(X_{1i} = 1\) αν το άτομο είναι

medium\(X_{1i} = 0\) αν το άτομο δεν είναι

medium(shortήtall)

\(X_{2i}\) = Αν το άτομο ανήκει στην ομάδα tall

Ψευδομεταβλητή (dummy variable) για την ομάδα

tall\(X_{2i} = 1\) αν το άτομο είναι

tall\(X_{2i} = 0\) αν το άτομο δεν είναι

tall(shortήmedium)

Κωδικοποίηση ψευδομεταβλητών:

| Ομάδα | \(X_{1i}\) | \(X_{2i}\) | Πρόβλεψη |

|---|---|---|---|

| short | 0 | 0 | 56.071 |

| medium | 1 | 0 | 60.224 |

| tall | 0 | 1 | 64.094 |

Παρατηρήσεις:

Η ομάδα

shortείναι η ομάδα αναφοράς (reference group)Δεν χρειάζεται ψευδομεταβλητή για την

shortγιατί αναπαρίσταται με \(X_{1i} = 0\) και \(X_{2i} = 0\)Για \(k\) ομάδες χρειαζόμαστε \(k-1\) ψευδομεταβλητές

Εδώ: 3 ομάδες → 2 ψευδομεταβλητές (\(X_1\) και \(X_2\))

Υπολογισμοί:

Ερμηνεία του Μοντέλου της Height3Group

Το \(b_0\) είναι ο μέσος όρος της ομάδας short. Το \(b_1\) είναι η ποσότητα που πρέπει να προστεθεί στην ομάδα short για να πάρουμε το μέσο όρο της ομάδας medium. Και το \(b_2\) είναι η ποσότητα που πρέπει να προστεθεί στην ομάδα short για να πάρουμε το μέσο όρο της ομάδας tall.

Μπορούμε να αντικαταστήσουμε τις εκτιμήσεις των παραμέτρων στην εξίσωση του μοντέλου, ως εξής:

\[\text{Thumb}_i = 56.071 + 4.153 X_{1i} + 8.023 X_{2i} + e_i\] Ή, πιο συγκεκριμένα, ως εξής:

\[\text{Thumb}_i = 56.071 + 4.153 \text{Height3Groupmedium}_i + 8.023 \text{Height3Grouptall}_i + e_i\] Όπως και πριν, είναι χρήσιμο να κατανοήσουμε πώς ακριβώς κωδικοποιούνται οι μεταβλητές \(Χ\). Στο μοντέλο τριών ομάδων έχουμε τώρα δύο μεταβλητές αντί για μία, \(X_{i1}\) και \(X_{i2}\). Οι νέοι δείκτες (1 και 2) απλώς διακρίνουν μεταξύ αυτών των δύο μεταβλητών· αντί να τους δώσουμε διαφορετικά ονόματα, τις ονομάζουμε συνήθως medium και tall.

Ο δείκτης \(i\) δείχνει ότι αυτές δεν είναι εκτιμήσεις παραμέτρων, αλλά μεταβλητές, που σημαίνει ότι κάθε παρατήρηση στο σύνολο δεδομένων θα έχει τις δικές της τιμές στις δύο μεταβλητές. Όπως και πριν, είναι λίγο δύσκολο να καταλάβουμε ποιες είναι οι πιθανές τιμές σε αυτές τις δύο μεταβλητές, και επίσης πώς αποδίδονται οι τιμές σε κάθε παρατήρηση.

Ποια είναι η διαφορά μεταξύ εκτίμησης παραμέτρου και μεταβλητής; (Υπάρχουν περισσότερες από μία σωστές απαντήσεις.)

Σωστές απαντήσεις: Β, Γ, και Δ

Το μοντέλο:

\[\text{Thumb}_i = b_0 + b_1X_{1i} + b_2X_{2i} + e_i\]

Β. Οι εκτιμήσεις παραμέτρων είναι οι ίδιες για κάθε άτομο - ΣΩΣΤΟ ✓

Εκτιμήσεις παραμέτρων (σταθερές για όλους):

\(b_0 = 56.071\) mm

\(b_1 = 4.153\) mm

\(b_2 = 8.023\) mm

Μεταβλητές (διαφέρουν για κάθε άτομο):

\(X_{1i}\): 0 ή 1 (ανάλογα με την ομάδα)

\(X_{2i}\): 0 ή 1 (ανάλογα με την ομάδα)

\(Y_i\): διαφορετικό μήκος αντίχειρα για κάθε άτομο

Γ. Το μήκος αντίχειρα αποτελείται από τις ίδιες εκτιμήσεις παραμέτρων αλλά διαφορετικές τιμές για τις μεταβλητές - ΣΩΣΤΟ ✓

Παράδειγμα:

# Άτομο 1 (short): X1=0, X2=0

Thumb₁ = 56.071 + 4.153(0) + 8.023(0) = 56.071 mm

# Άτομο 2 (medium): X1=1, X2=0

Thumb₂ = 56.071 + 4.153(1) + 8.023(0) = 60.224 mm

# Άτομο 3 (tall): X1=0, X2=1

Thumb₃ = 56.071 + 4.153(0) + 8.023(1) = 64.094 mmΟι εκτιμήσεις παραμέτρων (56.071, 4.153, 8.023) είναι οι ίδιες και για τα τρία άτομα.

Οι τιμές των μεταβλητών (\(X_1\), \(X_2\)) διαφέρουν για κάθε άτομο.

Δ. Οι μεταβλητές έχουν δείκτη i - ΣΩΣΤΟ ✓

Με δείκτη \(i\) (μεταβλητές):

\(Y_i\) - διαφορετικό για κάθε άτομο \(i\)

\(X_{1i}\) - διαφορετικό για κάθε άτομο \(i\)

\(X_{2i}\) - διαφορετικό για κάθε άτομο \(i\)

\(e_i\) - διαφορετικό υπόλοιπο για κάθε άτομο \(i\)

Χωρίς δείκτη \(i\) (εκτιμήσεις):

\(b_0\) - σταθερό για όλους

\(b_1\) - σταθερό για όλους

\(b_2\) - σταθερό για όλους

Γιατί η Α είναι λάθος:

Α. “Παράμετροι με λατινικά, μεταβλητές με ελληνικά” - ΛΑΘΟΣ

Αυτό είναι ανάποδα:

Παράμετροι: \(\beta_0, \beta_1, \beta_2\) (άγνωστες παράμετροι πληθυσμού)

Εκτιμήσεις παραμέτρων: \(b_0, b_1, b_2\) (εκτιμήσεις από δείγμα)

-

Μεταβλητές: χρησιμοποιούν λατινικά γράμματα (X, Y)

\(Y_i\) - εξαρτημένη μεταβλητή

\(X_{1i}, X_{2i}\) - ανεξάρτητες μεταβλητές

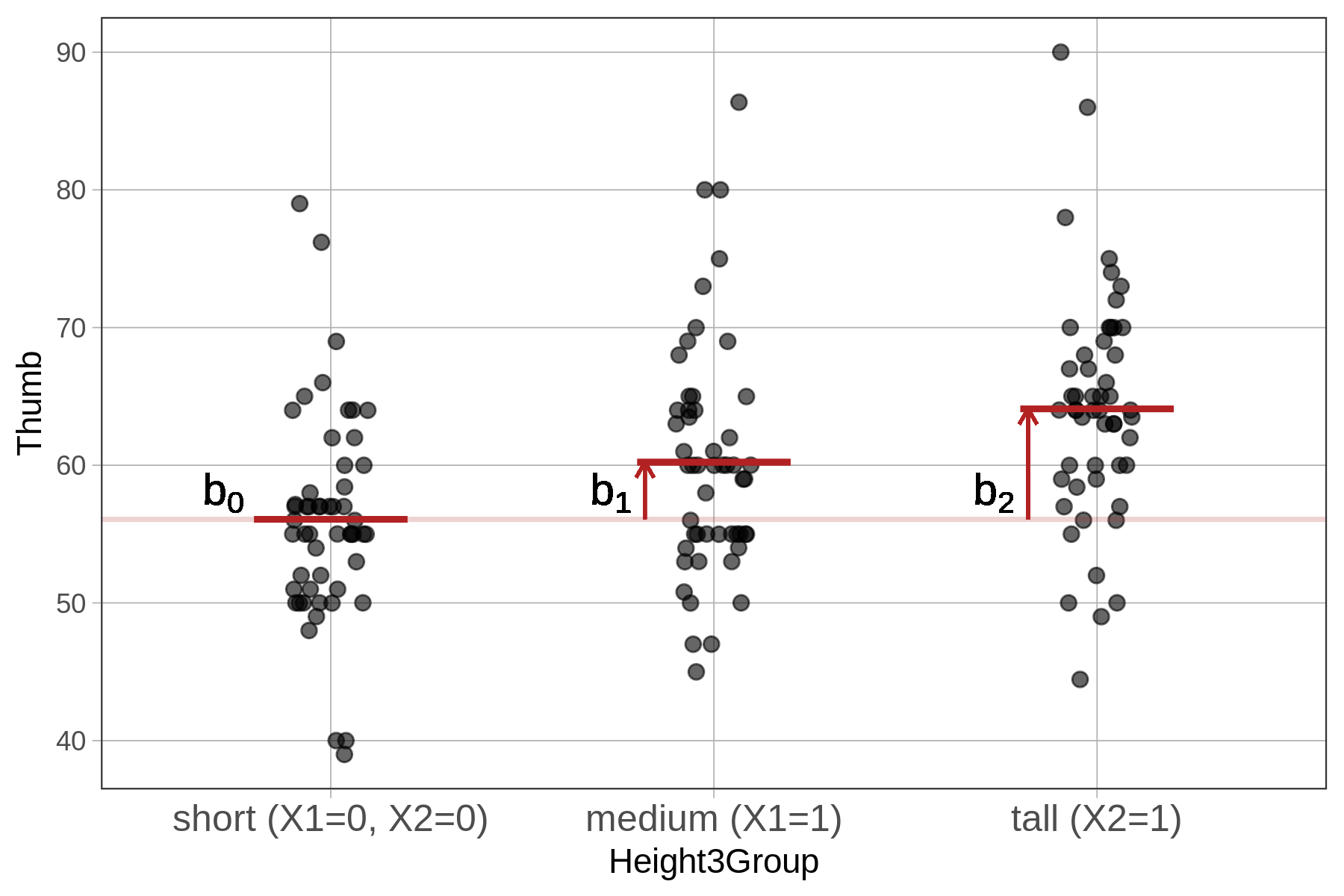

Η συνάρτηση lm() στην R δεν χρησιμοποιεί απαραίτητα την ίδια κωδικοποίηση που έχετε επιλέξει εσείς για μια μεταβλητή. Στο μοντέλο της Height3Group δημιουργήσαμε μια ποιοτική ανεξάρτητη μεταβλητή (Height3Group), όπου η κατηγορία 1 αντιστοιχεί σε short, η κατηγορία 2 σε medium και η κατηγορία 3 σε tall. Ωστόσο, η lm() μετατρέπει αυτή τη μία μεταβλητή σε δύο νέες μεταβλητές, \(X_1\) και \(X_2\), οι οποίες είναι κωδικοποιημένες ως ψευδομεταβλητές (dummy variables). Αυτό σημαίνει ότι για κάθε παρατήρηση οι τιμές τους μπορούν να είναι μόνο 0 ή 1.

Ας δούμε πώς γίνεται η κωδικοποίηση των ψευδομεταβλητών:

Για ένα άτομο στην ομάδα short, το μοντέλο του αποδίδει την τιμή 56.07, που είναι ο μέσος όρος της ομάδας short. Αυτή η τιμή είναι το \(b_0\). Η \(X_1\) μπορεί να θεωρηθεί ως μια μεταβλητή που «ρωτάει» για κάθε άτομο: «Ανήκει αυτό το άτομο στην ομάδα medium;». Η τιμή 0 σημαίνει «όχι» και η τιμή 1 σημαίνει «ναι». Ομοίως, η \(X_2\) δείχνει αν ένα άτομο ανήκει στην ομάδα tall. Για τα άτομα της ομάδας short, και οι δύο ψευδομεταβλητές \(X_1\) και \(X_2\) παίρνουν την τιμή 0, καθώς δεν ανήκουν ούτε στην medium ούτε στην tall.

Ας υπολογίσουμε την εξίσωση για ένα άτομο στην ομάδα short.

\[Y_i = 56.07 + 4.15X_{1i} + 8.02X_{2i} + e_i\]

Ποια είναι η σωστή εξίσωση για ένα άτομο στην ομάδα short;

Σωστή απάντηση: Α

Το μοντέλο:

\[Y_i = 56.07 + 4.15X_{1i} + 8.02X_{2i} + e_i\]

όπου:

\(X_{1i}\) = 1 αν

medium, 0 διαφορετικά\(X_{2i}\) = 1 αν

tall, 0 διαφορετικά

Για κάποιον στην ομάδα short:

Η ομάδα short είναι η ομάδα αναφοράς (reference group), οπότε:

\(X_{1i} = 0\) (δεν είναι

medium)\(X_{2i} = 0\) (δεν είναι

tall)

Αντικατάσταση στο μοντέλο:

\[Y_i = 56.07 + 4.15(0) + 8.02(0) + e_i\]

\[Y_i = 56.07 + 0 + 0 + e_i\]

\[Y_i = 56.07 + e_i\]

Άρα η πρόβλεψη για την ομάδα short είναι 56.07 mm (όταν \(e_i = 0\)).

Γιατί οι άλλες είναι λάθος:

Β. \(56.07 \times 0 + 4.15 + 8.02 \times 0 + e_i\) - ΛΑΘΟΣ

Πολλαπλασιάζει το Intercept (\(b_0 = 56.07\)) με 0

Το

Ιnterceptείναι εκτίμηση παραμέτρου, όχι μεταβλητή - δεν πολλαπλασιάζεται με τίποταΤο \(b_0\) πάντα προστίθεται ως σταθερός όρος

Θα έδινε: \(0 + 4.15 + 0 + e_i = 4.15 + e_i\) (εντελώς λάθος)

Γ. \(56.07 + 4.15 + 8.02 \times 0 + e_i\) - ΛΑΘΟΣ

Ίδιο λάθος με το Β

Θα έδινε: \(56.07 + 4.15 = 60.22\) mm (που είναι η τιμή για

medium, όχιshort)

Δ. \(56.07 + 4.15 + 8.02 + e_i\) - ΛΑΘΟΣ

Αυτό υποθέτει ότι και τα δύο \(X_{1i}\) και \(X_{2i}\) είναι 1

Αλλά ένα άτομο δεν μπορεί να είναι ταυτόχρονα

mediumκαιtallΘα έδινε: \(56.07 + 4.15 + 8.02 = 68.24\) mm (που δεν αντιστοιχεί σε καμία ομάδα)

Σύνοψη - Κωδικοποίηση για τις τρεις ομάδες:

| Ομάδα | \(X_{1i}\) | \(X_{2i}\) | Εξίσωση | Πρόβλεψη |

|---|---|---|---|---|

short |

0 | 0 | \(56.07 + 4.15(0) + 8.02(0) + e_i\) | 56.07 mm |

medium |

1 | 0 | \(56.07 + 4.15(1) + 8.02(0) + e_i\) | 60.22 mm |

tall |

0 | 1 | \(56.07 + 4.15(0) + 8.02(1) + e_i\) | 64.09 mm |

Κλειδί: Για την ομάδα short, και οι δύο ψευδομεταβλητές είναι 0, οπότε απλά παίρνουμε το Ιntercept (\(b_0 = 56.07\)).

Ας υπολογίσουμε την εξίσωση για ένα άτομο στην ομάδα medium.

\[Y_i = 56.07 + 4.15X_{1i} + 8.02X_{2i} + e_i\]

Ποια είναι η σωστή εξίσωση για ένα άτομο στην ομάδα medium;

Σωστή απάντηση: Β

Το μοντέλο:

\[Y_i = 56.07 + 4.15X_{1i} + 8.02X_{2i} + e_i\]

όπου:

\(X_{1i}\) = 1 αν

medium, 0 διαφορετικά\(X_{2i}\) = 1 αν

tall, 0 διαφορετικά

Για κάποιον στην ομάδα medium:

\(X_{1i} = 1\) (ναι, είναι

medium)\(X_{2i} = 0\) (όχι, δεν είναι

tall)

Αντικατάσταση στο μοντέλο:

\[Y_i = 56.07 + 4.15(1) + 8.02(0) + e_i\]

\[Y_i = 56.07 + 4.15 + 0 + e_i\]

\[Y_i = 60.22 + e_i\]

Άρα η πρόβλεψη για την ομάδα medium είναι 60.22 mm (όταν \(e_i = 0\)).

Γιατί οι άλλες είναι λάθος:

Α. \(56.07 + 4.15 \times 0 + 8.02 \times 0 + e_i\) - ΛΑΘΟΣ

Αυτό υποθέτει \(X_{1i} = 0\) και \(X_{2i} = 0\) (ομάδα

short)Αλλά κάποιος στην

mediumέχει \(X_{1i} = 1\)Θα έδινε: 56.07 mm (που είναι η τιμή για την

short, όχι τηνmedium)

Γ. \(56.07 \times 0 + 4.15 + 8.02 \times 0 + e_i\) - ΛΑΘΟΣ

Πολλαπλασιάζει το

Intercept(\(b_0 = 56.07\)) με 0Το

Interceptείναι εκτίμηση παράμετρου, όχι μεταβλητή - δεν πολλαπλασιάζεται με τίποταΤο \(b_0\) πάντα προστίθεται ως σταθερός όρος

Θα έδινε: \(0 + 4.15 + 0 + e_i = 4.15 + e_i\) (εντελώς λάθος)

Δ. \(56.07 + 4.15 + 8.02 + e_i\) - ΛΑΘΟΣ

Αυτό υποθέτει \(X_{1i} = 1\) και \(X_{2i} = 1\)

Αλλά ένα άτομο δεν μπορεί να είναι ταυτόχρονα

mediumκαιtallΓια

medium: \(X_{2i} = 0\), άρα το 8.02 πολλαπλασιάζεται με 0Θα έδινε: 68.24 mm (που δεν αντιστοιχεί σε καμία ομάδα)

Βήμα-βήμα υπολογισμός:

# Βήμα 1: Ταυτοποίηση των τιμών για `medium`

X1 = 1 # Είναι medium

X2 = 0 # Δεν είναι tall

# Βήμα 2: Αντικατάσταση στην εξίσωση

Y = 56.07 + 4.15*X1 + 8.02*X2 + e

# Βήμα 3: Υπολογισμός

Y = 56.07 + 4.15*(1) + 8.02*(0) + e

Y = 56.07 + 4.15 + 0 + e

Y = 60.22 + eΣύνοψη - Κωδικοποίηση για τις τρεις ομάδες:

| Ομάδα | \(X_{1i}\) | \(X_{2i}\) | Εξίσωση | Πρόβλεψη |

|---|---|---|---|---|

| short | 0 | 0 | \(56.07 + 4.15(0) + 8.02(0) + e_i\) | 56.07 mm |

| medium | 1 | 0 | \(56.07 + 4.15(1) + 8.02(0) + e_i\) | 60.22 mm |

| tall | 0 | 1 | \(56.07 + 4.15(0) + 8.02(1) + e_i\) | 64.09 mm |

Κλειδί: Για την ομάδα medium, το \(X_1 = 1\) οπότε προσθέτουμε το 4.15, αλλά το \(X_2 = 0\) οπότε δεν προσθέτουμε το 8.02.

Για ένα άτομο που ανήκει στην ομάδα medium, η τιμή της \(X_1\) θα είναι 1 (επειδή ανήκει στην ομάδα medium), ενώ η τιμή της \(X_2\) θα είναι 0 (επειδή δεν ανήκει στην ομάδα tall). Συνεπώς, το μοντέλο θα του αποδώσει προβλεπόμενο μήκος αντίχειρα ίσο με 56.07 + 4.15 = 60.22 χιλιοστά.

Παρατηρήστε ότι, σύμφωνα με τα αποτελέσματα της favstats() που ακολουθούν, ο μέσος όρος του μήκους του αντίχειρα για την ομάδα medium είναι πράγματι 60.22 χιλιοστά!

Height3Group min Q1 median Q3 max mean sd n missing

1 short 39.00 51.00 55 58.42 79.00 56.07113 7.499937 53 0

2 medium 45.00 55.00 60 64.00 86.36 60.22375 8.490406 52 0

3 tall 44.45 59.75 64 68.25 90.00 64.09365 8.388113 52 0Η διαδικασία της δημιουργίας ψευδομεταβλητών μετατρέπει τις ποιοτικές μεταβλητές σε ένα σύνολο δυαδικών μεταβλητών (0/1). Όπως φαίνεται και στον παρακάτω πίνακα, αποδίδοντας σε κάθε άτομο την τιμή 0 ή την τιμή 1 στις \(X_1\) και \(X_2\), μπορούμε να το κατατάξουμε εύκολα σε μία από τις τρεις κατηγορίες: short, medium ή tall.

| Κατηγορία (Ομάδα) | Κωδικοποίηση \(X_1\) | Κωδικοποίηση \(X_2\) |

|---|---|---|

short |

0 | 0 |

medium |

1 | 0 |

tall |

0 | 1 |

Ίσως αναρωτιέστε γιατί είναι απαραίτητο να γνωρίζετε όλες αυτές τις λεπτομέρειες σχετικά με το πώς η R κωδικοποιεί τις ψευδομεταβλητές για μια ποιοτική ανεξάρτητη μεταβλητή. Ο λόγος είναι ότι σας βοηθά να ερμηνεύετε σωστά τις παραμέτρους του μοντέλου. Για παράδειγμα, σας επιτρέπει να αντιληφθείτε πώς το μοντέλο υπολογίζει την τιμή πρόβλεψης για την τρίτη ομάδα, προσθέτοντας το \(b_2\) στο \(b_0\) (και όχι στο \(b_1\)). Σε αυτό το μάθημα, δεν θα σας ζητηθεί να υπολογίσετε αυτούς τους αριθμούς μόνοι σας· ο στόχος είναι να εστιάσετε στο νόημα των αριθμών και στο πώς αυτοί περιγράφουν τις διαφορές μεταξύ των ομάδων.

9.3 Σύγκριση της Προσαρμογής των Μοντέλων Δύο και Τριών Ομάδων

Εξέταση της Προσαρμογής του Μοντέλου Τριών Ομάδων

Μέχρι τώρα έχετε δημιουργήσει την ποιοτική ανεξάρτητη μεταβλητή Height3Group, εξετάσει τους μέσους όρους του μήκους αντίχειρα για κάθε ομάδα, προσαρμόσει το μοντέλο της Height3Group με τη συνάρτηση lm() και ερμηνεύσει τις εκτιμήσεις παραμέτρων, και μάθει πώς να αναπαριστάτε το μοντέλο τριών ομάδων με χρήση της σημειολογίας του GLM.

Το τελευταίο βήμα είναι να εξετάσετε τον πίνακα ANOVA για να συγκρίνετε την προσαρμογή του μοντέλου της Height3Group με το κενό μοντέλο. Μπορείτε να το κάνετε χρησιμοποιώντας τη συνάρτηση supernova(). Προσαρμόστε το μοντέλο της Height3Group και εμφανίστε τον πίνακα ANOVA.

Παρακάτω εμφανίζονται οι πίνακες ANOVA για τα δύο μοντέλα: πρώτα για το μοντέλο της Height2Group και στη συνέχεια για το μοντέλο της Height3Group, ώστε να μπορείτε να τα συγκρίνετε εύκολα.

Μοντέλο της Height2Group

Analysis of Variance Table (Type III SS)

Model: Thumb ~ Height2Group

SS df MS F PRE p

----- --------------- | --------- --- ------- ------ ------ -----

Model (error reduced) | 830.880 1 830.880 11.656 0.0699 .0008

Error (from model) | 11049.331 155 71.286

----- --------------- | --------- --- ------- ------ ------ -----

Total (empty model) | 11880.211 156 76.155Μοντέλο της Height3Group

Analysis of Variance Table (Type III SS)

Model: Thumb ~ Height3Group

SS df MS F PRE p

----- --------------- | --------- --- ------- ------ ------ -----

Model (error reduced) | 1690.440 2 845.220 12.774 0.1423 .0000

Error (from model) | 10189.770 154 66.167

----- --------------- | --------- --- ------- ------ ------ -----

Total (empty model) | 11880.211 156 76.155Παρατηρήστε τον πίνακα ANOVA για το μοντέλο της Height3Group. Ποια αναλογία της μεταβλητότητας στο μήκος αντίχειρα εξηγείται από αυτό το μοντέλο;

Σωστή απάντηση: Α - PRE (0.1423)

Τι σημαίνει PRE;

PRE = Proportional Reduction in Error (Αναλογική Μείωση του Σφάλματος)

Το PRE μετράει την αναλογία της μεταβλητότητας που εξηγείται από το μοντέλο.

Ο τύπος:

\[\text{PRE} = \frac{\text{SS}_{\text{Model}}}{\text{SS}_{\text{Total}}} = \frac{1690.440}{11880.211} = 0.1423\]

Ερμηνεία:

PRE = 0.1423 ή 14.23%

Το μοντέλο της Height3Group εξηγεί περίπου το 14% της μεταβλητότητας στο μήκος αντίχειρα

Το υπόλοιπο 86% παραμένει ανεξήγητο (οφείλεται σε άλλους παράγοντες)

Εναλλακτικοί υπολογισμοί:

Μπορείτε επίσης να το υπολογίσετε ως μείωση του σφάλματος:

\[\text{PRE} = \frac{\text{SS}_{\text{Total}} - \text{SS}_{\text{Error}}}{\text{SS}_{\text{Total}}} = \frac{11880.2 - 10189.8}{11880.2} = \frac{1690.4}{11880.2} = 0.1423\]

Γιατί οι άλλες είναι λάθος:

Β. \(SS_{Model}\) (1690.4) - ΛΑΘΟΣ

Αυτό είναι το άθροισμα τετραγώνων που εξηγείται από το μοντέλο

Έχει μονάδες μέτρησης (mm²)

Η ερώτηση ζητάει αναλογία (χωρίς μονάδες, 0-1)

Γ. \(SS_{Error}\) (10189.8) - ΛΑΘΟΣ

Αυτό είναι η ανεξήγητη μεταβλητότητα

Όχι η εξηγούμενη μεταβλητότητα

Αντιπροσωπεύει το σφάλμα που απομένει μετά το μοντέλο

Δ. \(SS_{Total}\) (11880.2) - ΛΑΘΟΣ

Αυτό είναι η συνολική μεταβλητότητα

Όχι η αναλογία που εξηγείται

Είναι το άθροισμα: \(SS_{Model} + SS_{Error}\)

Συμπέρασμα:

Το PRE = 0.1423 είναι η σωστή απάντηση γιατί:

Είναι αναλογία (0-1), όχι απόλυτη τιμή

Μετράει την εξηγούμενη μεταβλητότητα

Υπολογίζεται ως \(\frac{SS_{Model}}{SS_{Total}}\)

Απαντάει άμεσα στην ερώτηση: «Ποια αναλογία εξηγείται;»

Συγκρίνετε τους πίνακες ANOVA για τα μοντέλα της Height3Group και της Height2Group. Γιατί το συνολικό Άθροισμα Τετραγώνων (Total SS) είναι το ίδιο και για τα δύο μοντέλα;

Σωστή απάντηση: Δ - Και τα δύο έχουν την ίδια εξαρτημένη μεταβλητή

Τι είναι το SS\(_{\text{Total}}\);

\[\text{SS}_{\text{Total}} = \sum_{i=1}^{n}(Y_i - \bar{Y})^2\]

Το SS\(_{\text{Total}}\) μετράει τη συνολική μεταβλητότητα της εξαρτημένης μεταβλητής από το γενικό μέσο όρο.

Και τα δύο μοντέλα:

Height2Group:

Thumb ~ Height2GroupHeight3Group:

Thumb ~ Height3Group

προσπαθούν να εξηγήσουν το μήκος αντίχειρα.

Γιατί το SS\(_{\text{Total}}\) είναι το ίδιο (11880.211);

Ίδια εξαρτημένη μεταβλητή: Και τα δύο μοντέλα χρησιμοποιούν την ίδια μεταβλητή \(Y\) (Thumb)

Ίδια δεδομένα: Και τα δύο χρησιμοποιούν το ίδιο σύνολο δεδομένων (n = 157 άτομα)

Ίδιος γενικός μέσος όρος: Ο μέσος όρος του μήκους αντίχειρα είναι ο ίδιος

Το SS\(_{\text{Total}}\) δεν εξαρτάται από το μοντέλο - εξαρτάται μόνο από:

Τη μεταβλητότητα της \(Y\) (Thumb)

Τον αριθμό των παρατηρήσεων

Γιατί οι άλλες είναι λάθος:

Α. “Ίδια ανεξάρτητη μεταβλητή” - ΛΑΘΟΣ

-

Οι ανεξάρτητες μεταβλητές είναι διαφορετικές:

Height2Group: 2 κατηγορίες (short, tall)

Height3Group: 3 κατηγορίες (short, medium, tall)

Και οι δύο βασίζονται στο ύψος (Height), αλλά με διαφορετική κατηγοριοποίηση

Β. “Ποιοτική ανεξάρτητη μεταβλητή” - ΛΑΘΟΣ

Ναι, και οι δύο χρησιμοποιούν ποιοτική μεταβλητή

Αλλά αυτός δεν είναι ο λόγος για τον οποίο το SS\(_{\text{Total}}\) είναι ίδιο

Το SS\(_{\text{Total}}\) θα ήταν ίδιο ακόμα και με ποσοτική ανεξάρτητη μεταβλητή

Γ. “Ποσοτική μεταβλητή” - ΛΑΘΟΣ

Και τα δύο χρησιμοποιούν ποιοτική ανεξάρτητη μεταβλητή (ομάδες ύψους)

Όχι ποσοτική

Αν και το Height (ύψος) είναι ποσοτική, οι Height2Group και Height3Group είναι ποιοτικές

Συμπέρασμα:

Το SS\(_{\text{Total}}\) είναι το ίδιο επειδή και τα δύο μοντέλα εξηγούν την ίδια εξαρτημένη μεταβλητή (Thumb) χρησιμοποιώντας τα ίδια δεδομένα. Η συνολική μεταβλητότητα της \(Y\) δεν αλλάζει - αλλάζει μόνο πόσο καλά την εξηγούμε.

Ποιο μοντέλο προσαρμόζεται καλύτερα στα δεδομένα;

Πώς μπορείτε να καταλάβετε ποιο μοντέλο προσαρμόζεται καλύτερα στα δεδομένα; (Υπάρχουν περισσότερες από μία σωστές απαντήσεις.)

Πρώτη ερώτηση - Σωστή απάντηση: Α - Height3Group

Δεύτερη ερώτηση - Σωστές απαντήσεις: Β, Γ, και Δ

Πώς συγκρίνουμε μοντέλα;

| Μέτρο | Height2Group | Height3Group | Καλύτερο |

|---|---|---|---|

| PRE | 0.0699 (7%) | 0.1423 (14%) | Height3Group ✓ |

| SS\(_{\text{Model}}\) | 830.880 | 1690.440 | Height3Group ✓ |

| SS\(_{\text{Error}}\) | 11049.331 | 10189.770 | Height3Group ✓ |

| SS\(_{\text{Total}}\) | 11880.211 | 11880.211 | Ίδιο |

Β. Μεγαλύτερο PRE - ΣΩΣΤΟ ✓

PRE = Proportional Reduction in Error

Μετράει την αναλογία της μεταβλητότητας που εξηγείται

Height3Group: PRE = 0.1423 (14.23%)

Height2Group: PRE = 0.0699 (6.99%)

Μεγαλύτερο PRE = καλύτερο μοντέλο

\[\text{PRE} = \frac{\text{SS}_{\text{Model}}}{\text{SS}_{\text{Total}}}\]

Γ. Μεγαλύτερο SS Model - ΣΩΣΤΟ ✓

SS\(_{\text{Model}}\) = η μεταβλητότητα που εξηγείται από το μοντέλο

Height3Group: SS\(_{\text{Model}}\) = 1690.440

Height2Group: SS\(_{\text{Model}}\) = 830.880

Μεγαλύτερο SS\(_{\text{Model}}\) = περισσότερη εξηγούμενη μεταβλητότητα = καλύτερο μοντέλο

Δ. Μικρότερο SS Error - ΣΩΣΤΟ ✓

SS\(_{\text{Error}}\) = η μεταβλητότητα που δεν εξηγείται (υπολειπόμενο σφάλμα)

Height3Group: SS\(_{\text{Error}}\) = 10189.770

Height2Group: SS\(_{\text{Error}}\) = 11049.331

Μικρότερο SS\(_{\text{Error}}\) = λιγότερο ανεξήγητο σφάλμα = καλύτερο μοντέλο

Γιατί οι άλλες είναι λάθος:

Α. “Μεγαλύτερο SS Total” - ΛΑΘΟΣ

Το SS\(_{\text{Total}}\) είναι το ίδιο και για τα δύο μοντέλα (11880.211)

Εξαρτάται μόνο από τη μεταβλητότητα της εξαρτημένης μεταβλητής (Thumb)

Δεν αλλάζει με το μοντέλο

Ε. “Μικρότερο SS Total” - ΛΑΘΟΣ

Ίδιος λόγος με το Α

Το SS\(_{\text{Total}}\) δεν σχετίζεται με την ποιότητα του μοντέλου

Η σχέση:

\[\text{SS}_{\text{Total}} = \text{SS}_{\text{Model}} + \text{SS}_{\text{Error}}\]

Αφού το SS\(_{\text{Total}}\) είναι σταθερό:

Όταν το SS\(_{\text{Model}}\) ↑ → το SS\(_{\text{Error}}\) ↓

Καλύτερο μοντέλο = περισσότερη εξηγούμενη, λιγότερη ανεξήγητη μεταβλητότητα

Συμπέρασμα:

Το μοντέλο της Height3Group είναι καλύτερο μοντέλο επειδή:

Εξηγεί διπλάσια μεταβλητότητα (14% vs 7%)

Έχει μεγαλύτερο SS\(_{\text{Model}}\) (1690 vs 831)

Έχει μικρότερο SS\(_{\text{Error}}\) (10190 vs 11049)

Το SS\(_{\text{Total}}\) δεν έχει σημασία - είναι το ίδιο για όλα τα μοντέλα με την ίδια εξαρτημένη μεταβλητή

Γιατί νομίζετε ότι αυτό το μοντέλο (της Height3Group) είναι καλύτερο;

Σωστή απάντηση: Β - Πιο ακριβείς προβλέψεις, μικρότερα υπόλοιπα

Γιατί το μοντέλο της Height3Group είναι καλύτερο;

Το μοντέλο της Height3Group χωρίζει τα δεδομένα σε 3 ομάδες αντί για 2, επιτρέποντας:

Πιο εξειδικευμένες προβλέψεις

Καλύτερη προσαρμογή στα δεδομένα

Μικρότερα υπόλοιπα (residuals)

Σύγκριση:

| Μοντέλο | Προβλέψεις | SS\(_{\text{Error}}\) | PRE |

|---|---|---|---|

| Height2Group | 2 μέσοι όροι: • short: 57.82 mm • tall: 62.42 mm |

11049.3 | 7% |

| Height3Group | 3 μέσοι όροι: • short: 56.07 mm • medium: 60.22 mm • tall: 64.09 mm |

10189.8 | 14% |

Τι σημαίνει “πιο ακριβείς προβλέψεις”;

Με 3 ομάδες αντί για 2:

Τα άτομα μεσαίου ύψους παίρνουν τη δική τους πρόβλεψη (60.22 mm)

Δεν αναγκάζονται να ομαδοποιηθούν με τους κοντούς ή τους ψηλούς

Οι προβλέψεις είναι πιο κοντά στις πραγματικές τιμές

Μείωση υπολοίπων:

Μικρότερα υπόλοιπα = οι προβλέψεις είναι πιο κοντά στις πραγματικές τιμές

SS\(_{\text{Error}}\) μειώθηκε από 11049 → 10189 (μείωση ~860 mm²)

Γιατί οι άλλες είναι λάθος:

Α. “Λιγότερη συνολική μεταβλητότητα” - ΛΑΘΟΣ

Το SS\(_{\text{Total}}\) είναι το ίδιο και για τα δύο μοντέλα (11880.2)

Η συνολική μεταβλητότητα εξαρτάται από τα δεδομένα, όχι από το μοντέλο

Και τα δύο μοντέλα χρησιμοποιούν τα ίδια δεδομένα

Γ. “Εύρος προβλέψεων για κάθε άτομο” - ΛΑΘΟΣ

Κάθε μοντέλο κάνει μία πρόβλεψη ανά άτομο (το μέσο όρο της ομάδας του)

Δεν κάνει “εύρος” προβλέψεων

Δ. “Μοντέλα 2 ομάδων πάντα καλύτερα” - ΛΑΘΟΣ

Αυτό είναι το αντίθετο από αυτό που ισχύει

Τα πιο σύνθετα μοντέλα (με περισσότερες ομάδες) συχνά προσαρμόζονται καλύτερα στα δεδομένα

Η απλότητα ενός μοντέλου είναι επιθυμητή, αλλά όχι εις βάρος της ακρίβειας της πρόβλεψης

Εδώ, το μοντέλο της Height3Group έχει σαφώς καλύτερη προσαρμογή (PRE: 14% vs 7%)

Ε. “Έτυχε” - ΛΑΘΟΣ

Αυτό δεν είναι σύμπτωση

Υπάρχει συστηματική βελτίωση όταν προσθέτουμε μια ομάδα

Συμπέρασμα:

Το μοντέλο της Height3Group είναι καλύτερο επειδή παράγει πιο ακριβείς προβλέψεις με τη δημιουργία μιας ξεχωριστής ομάδας για τα άτομα μεσαίου ύψους. Αυτό μειώνει τα υπόλοιπα (SS\(_{\text{Error}}\)) και αυξάνει την εξηγούμενη μεταβλητότητα (PRE).

Σε επόμενο κεφάλαιο θα μάθουμε πώς να συγκρίνουμε άμεσα τα δύο μοντέλα μεταξύ τους. Προς το παρόν, θα περιοριστούμε στη σύγκριση κάθε μοντέλου με το κενό μοντέλο.

Βελτίωση Μοντέλων με την Προσθήκη Παραμέτρων

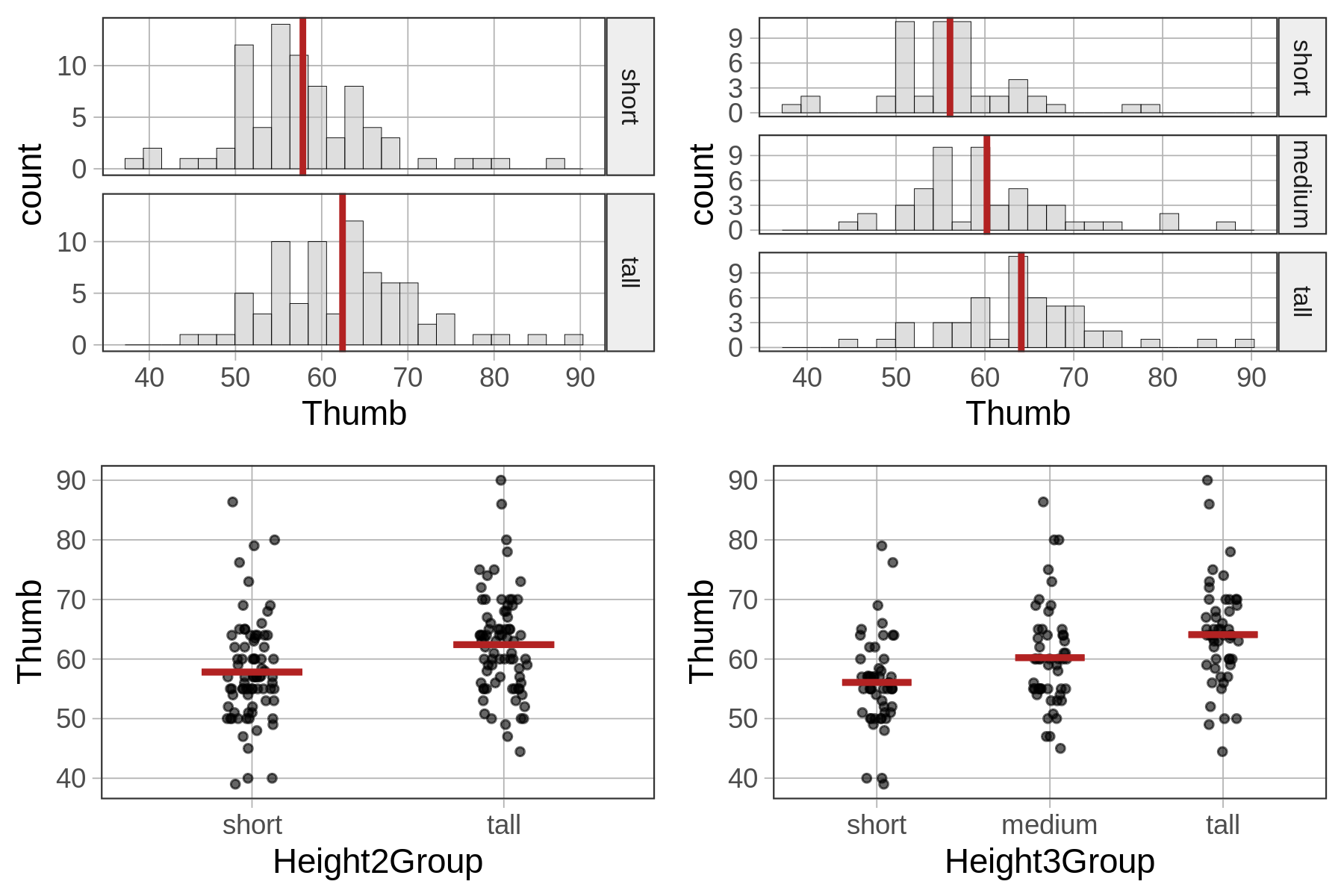

Όπως είδαμε παραπάνω, το μοντέλο της Height3Group εξηγεί μεγαλύτερο ποσοστό της μεταβλητότητας σε σχέση με το μοντέλο της Height2Group. Με άλλα λόγια, μειώνει περισσότερο το ανεξήγητο σφάλμα σε σύγκριση με το κενό μοντέλο. Αυτό φαίνεται καθαρά αν συγκρίνετε τις τιμές του PRE (.14 έναντι .07, αντίστοιχα).

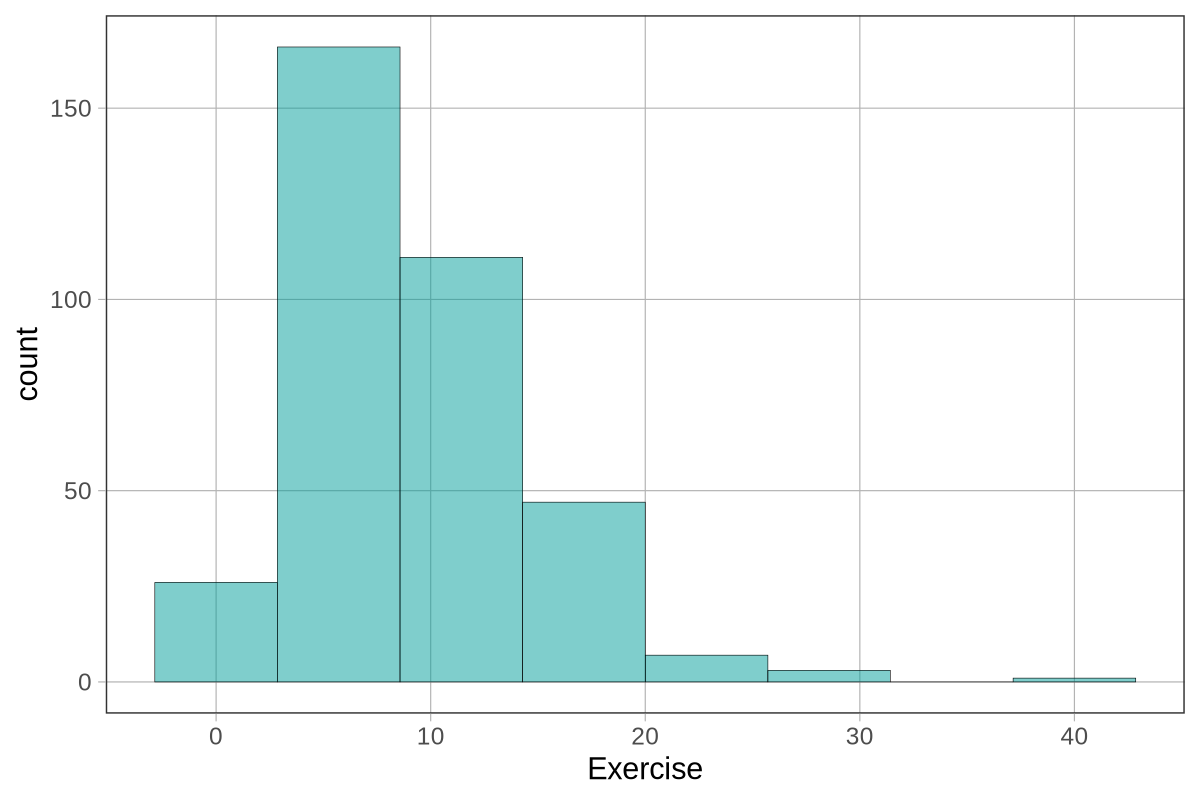

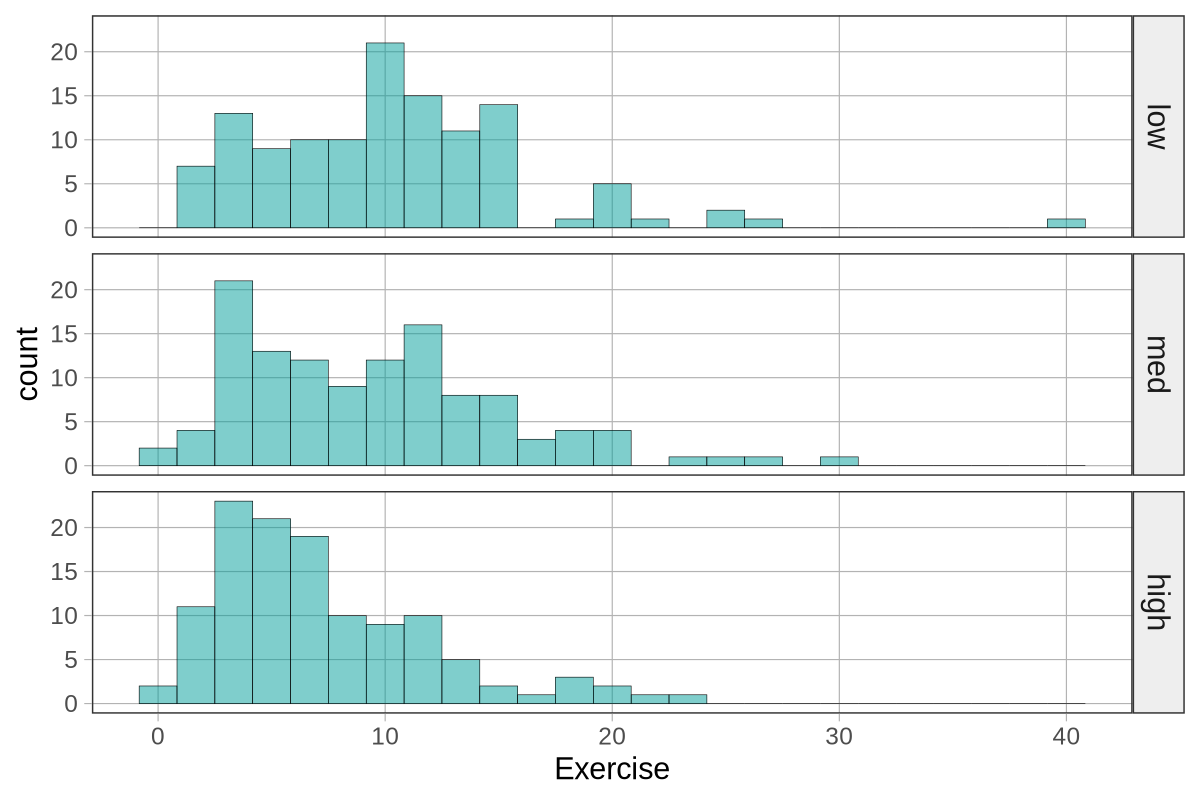

Αν εξετάσετε τα παρακάτω ιστογράμματα και τα διαγράμματα jitter για το μοντέλο δύο ομάδων και το μοντέλο τριών ομάδων, αντίστοιχα, θα κατανοήσετε γιατί συμβαίνει αυτό. Όσο προσθέτουμε στο μοντέλο περισσότερες ομάδες ύψους, μειώνουμε τη μεταβλητότητα των υπολοίπων γύρω από το μέσο όρο του ύψους για κάθε ομάδα, κάτι που οδηγεί σε καλύτερη προσαρμογή του μοντέλου.

Γενικά, όσο περισσότερες παραμέτρους προσθέτουμε σε ένα μοντέλο, τόσο μικρότερο γίνεται το υπολειπόμενο σφάλμα μετά την αφαίρεση της επίδρασης του μοντέλου. Αν και αυτό δεν ισχύει πάντα, συνήθως τα πιο σύνθετα μοντέλα έχουν υψηλότερες τιμές PRE. Εφόσον ο στόχος μας είναι να μειώσουμε το σφάλμα, η αυξημένη πολυπλοκότητα φαίνεται αρχικά επιθυμητή — και πράγματι είναι, αλλά μόνο μέχρι ενός σημείου.

Ας κάνουμε ένα μικρό πείραμα σκέψης. Γνωρίζουμε ήδη ότι το μοντέλο τριών ομάδων εξηγεί περισσότερη μεταβλητότητα από το μοντέλο δύο ομάδων. Με την ίδια λογική, το μοντέλο τεσσάρων ομάδων θα εξηγούσε ακόμη περισσότερη, και ούτω καθεξής. Τι θα συνέβαινε, όμως, αν συνεχίζαμε να διαιρούμε τη μεταβλητή του ύψους σε όλο και περισσότερες ομάδες, μέχρι τελικά κάθε άτομο να ανήκει στη δική του ξεχωριστή ομάδα;

Αν το κάναμε αυτό, το σφάλμα θα μηδενιζόταν. Γιατί; Επειδή κάθε άτομο θα είχε τη δική του παράμετρο στο μοντέλο, και η τιμή πρόβλεψης για κάθε άτομο θα ήταν ακριβώς ίση με την πραγματική του τιμή. Δεν θα υπήρχε λοιπόν καμία διαφορά — κανένα υπόλοιπο — μεταξύ τιμής πρόβλεψης και πραγματικής τιμής. Με αυτόν τον τρόπο, όλη η μεταβλητότητα θα φαινόταν να εξηγείται από το μοντέλο.

Ωστόσο, αυτό οδηγεί σε δύο σημαντικά προβλήματα:

Πρώτον, αν και το μοντέλο θα προσαρμοζόταν τέλεια στα δεδομένα μας, δεν θα αναμενόταν να αποδώσει εξίσου καλά σε ένα νέο δείγμα, καθώς τα άτομα θα ήταν διαφορετικά.

Δεύτερον, ο σκοπός της αυξημένης πολυπλοκότητας είναι να μας βοηθήσει να κατανοήσουμε καλύτερα τη Διαδικασία Παραγωγής των Δεδομένων. Είναι λογικό να προσθέτουμε παραμέτρους όταν αυτό οδηγεί σε βαθύτερη κατανόηση του φαινομένου που μελετάμε. Αν, όμως, καταλήξουμε να έχουμε τόσες παραμέτρους όσες και παρατηρήσεις, τότε έχουμε προσθέσει πολυπλοκότητα χωρίς να έχουμε κερδίσει καμία ουσιαστική γνώση για τη διαδικασία που δημιουργεί τα δεδομένα.

Παρόλο που μπορούμε να βελτιώσουμε την προσαρμογή ενός μοντέλου προσθέτοντας περισσότερες παραμέτρους, υπάρχει πάντα ένας συμβιβασμός μεταξύ της μείωσης του σφάλματος, από τη μία πλευρά, και της διατήρησης της απλότητας, της ερμηνευσιμότητας και της κομψότητας του μοντέλου, από την άλλη.

Αυτός είναι και ένας βασικός περιορισμός του PRE ως μέτρου της επιτυχίας ενός μοντέλου στη μείωση του σφάλματος. Για παράδειγμα, μια τιμή PRE = .40 θα ήταν αρκετά εντυπωσιακή αν προέκυπτε με την προσθήκη μόνο μίας παραμέτρου. Αν όμως είχαμε το ίδιο αποτέλεσμα μετά την προσθήκη δέκα παραμέτρων, τότε η επίδοση αυτή δεν θα θεωρούνταν ιδιαίτερα αξιοσημείωτη. Αυτό το φαινόμενο είναι γνωστό στους στατιστικολόγους ως υπερπροσαρμογή (overfitting), δηλαδή η υπερβολική προσαρμογή ενός μοντέλου στα συγκεκριμένα δεδομένα του δείγματος, με αποτέλεσμα να χάνει τη γενικευσιμότητά του.

Ένα γνωμικό που αποδίδεται στον Αϊνστάιν συνοψίζει άψογα αυτή την ιδέα: «Όλα πρέπει να γίνονται όσο πιο απλά είναι δυνατόν, αλλά όχι απλούστερα.» Μια ορισμένη ποσότητα πολυπλοκότητας είναι αναπόφευκτη — τα μοντέλα μας πρέπει να αντικατοπτρίζουν, έστω και μερικώς, την πολυπλοκότητα του πραγματικού κόσμου. Ωστόσο, όσο μπορούμε να διατηρούμε τα μοντέλα μας απλά, χωρίς να χάνουμε τη δυνατότητα να κατανοούμε το φαινόμενο ή να κάνουμε επαρκώς ακριβείς προβλέψεις, τόσο το καλύτερο.

Ο στόχος της δημιουργίας ενός στατιστικού μοντέλου δεν είναι απλώς η μείωση του σφάλματος. Θέλουμε, φυσικά, να μειώσουμε το σφάλμα όσο το δυνατόν περισσότερο, αλλά αυτό δεν είναι ο μοναδικός μας σκοπός. Ποιοι άλλοι στόχοι πρέπει να μας καθοδηγούν όταν κατασκευάζουμε ένα μοντέλο;

Σωστή απάντηση: Όλα τα Α, Β, Γ

Η δημιουργία ενός καλού στατιστικού μοντέλου απαιτεί την εξισορρόπηση πολλαπλών στόχων, όχι μόνο τη μείωση του σφάλματος.

Α. Κατανόηση της Διαδικασίας Παραγωγής των Δεδομένων - ΣΩΣΤΟ ✓

Τι είναι η ΔΠΔ;

Η Διαδικασία Παραγωγής Δεδομένων είναι ο υποκείμενος μηχανισμός που δημιουργεί τα δεδομένα που παρατηρούμε.

Παράδειγμα:

Ερώτημα: Γιατί τα ψηλότερα άτομα έχουν μεγαλύτερους αντίχειρες;

ΔΠΔ: Το ύψος και το μήκος αντίχειρα συσχετίζονται επειδή και τα δύο επηρεάζονται από γενετικούς παράγοντες, διατροφή, κλπ.

Το μοντέλο: Μας βοηθά να κατανοήσουμε αυτή τη σχέση

Γιατί είναι σημαντικό;

Θέλουμε να εξηγήσουμε φαινόμενα, όχι μόνο να προβλέψουμε

Κατανοώντας τη ΔΠΔ, μπορούμε να γενικεύσουμε σε νέες καταστάσεις

Μας βοηθά να λάβουμε αποφάσεις (π.χ., παρεμβάσεις)

Β. Καλές προβλέψεις - ΣΩΣΤΟ ✓

Γιατί χρειαζόμαστε προβλέψεις;

Ένα μοντέλο πρέπει να κάνει αρκετά καλές προβλέψεις για νέα δεδομένα.

Παράδειγμα:

Αν ξέρουμε ότι κάποιος είναι ψηλός, μπορούμε να προβλέψουμε ότι πιθανόν έχει μεγαλύτερο αντίχειρα

-

Το μοντέλο της

Height3Groupπροβλέπει:short: 56.07 mm

medium: 60.22 mm

tall: 64.09 mm

Αλλά όχι τέλειες προβλέψεις:

Δεν χρειάζεται να έχουμε μηδενικό σφάλμα

Αρκεί να είναι χρήσιμες προβλέψεις (καλύτερες από την τύχη)

Υπερβολική ακρίβεια μπορεί να οδηγήσει σε υπερπροσαρμογή (overfitting)

Γ. Εξισορρόπηση απλότητας και ακρίβειας μοντέλου - ΣΩΣΤΟ ✓

Το δίλημμα:

Απλότητα ←──────────────────→ Ακρίβεια

(λίγες παράμετροι) (πολλές παράμετροι)

Εύκολο να κατανοηθεί Καλύτερη προσαρμογή

Γενικεύει καλά Κίνδυνος υπερπροσαρμογήςΠαράδειγμα:

| Μοντέλο | Παράμετροι | PRE | Απλότητα vs Ακρίβεια |

|---|---|---|---|

| Κενό μοντέλο | 1 (\(b_0\)) | 0% | Πολύ απλό, καμία ακρίβεια |

| Height2Group | 2 (\(b_0, b_1\)) | 7% | Απλό, μέτρια ακρίβεια |

| Height3Group | 3 (\(b_0, b_1, b_2\)) | 14% | Πιο πολύπλοκο, καλύτερη ακρίβεια |

| Ατομικό μοντέλο | 157 παράμετροι | 100% | Πολύ πολύπλοκο, τέλεια προσαρμογή αλλά άχρηστο! |

Γιατί όχι πάντα το πιο ακριβές μοντέλο;

Υπερπροσαρμογή: Ένα μοντέλο με μια παράμετρο για κάθε άτομο θα έχει μηδενικό σφάλμα, αλλά θα είναι άχρηστο για νέα, άγνωστα δεδομένα

Ερμηνευσιμότητα: Απλούστερα μοντέλα είναι πιο εύκολο να κατανοηθούν

Γενίκευση: Απλούστερα μοντέλα συχνά λειτουργούν καλύτερα σε νέα δεδομένα

Η αρχή της απλότητας (Parsimony / Occam’s Razor):

«Προτιμήστε το απλούστερο μοντέλο που κάνει αρκετά καλή δουλειά.»

Γιατί όλα τα παραπάνω;

Ένα καλό μοντέλο πρέπει να:

-

Εξηγεί την υποκείμενη διαδικασία (ΔΠΔ)

Κατανοούμε γιατί υπάρχει η σχέση

π.χ., «Το ύψος σχετίζεται με το μήκος αντίχειρα»

-

Προβλέπει αρκετά καλά

Δίνει χρήσιμες εκτιμήσεις για νέες παρατηρήσεις

π.χ., PRE = 14% σημαίνει ότι εξηγούμε μέρος της μεταβλητότητας

-

Εξισορροπεί απλότητα και ακρίβεια

Όχι υπερβολικά απλό (χαμηλή ακρίβεια)

Όχι υπερβολικά πολύπλοκο (υπερπροσαρμογή)

π.χ., Height3Group: 3 παράμετροι = καλή ισορροπία

Παράδειγμα από τα δεδομένα μας:

Το μοντέλο της Height3Group ικανοποιεί και τους τρεις στόχους:

✓ Κατανόηση: Βλέπουμε ότι το ύψος συσχετίζεται θετικά με το μήκος αντίχειρα

✓ Πρόβλεψη: Εξηγεί 14% της μεταβλητότητας (αρκετά χρήσιμο)

✓ Ισορροπία: 3 παράμετροι = απλό αλλά όχι υπερβολικά απλό

Συμπέρασμα:

Η μοντελοποίηση δεν είναι μόνο για τη μείωση του σφάλματος. Χρειαζόμαστε μοντέλα που:

Μας βοηθούν να καταλάβουμε τον κόσμο (ΔΠΔ)

Κάνουν χρήσιμες προβλέψεις

Είναι αρκετά απλά για να γενικεύουν αλλά αρκετά πολύπλοκα για να είναι ακριβή

Όλοι αυτοί οι στόχοι είναι εξίσου σημαντικοί και πρέπει να λαμβάνονται ταυτόχρονα υπόψη!

Ποιο είναι το μειονέκτημα του PRE;

Σωστή απάντηση: Δ - Το PRE δεν λαμβάνει υπόψη την πολυπλοκότητα του μοντέλου

Το πρόβλημα με το PRE:

Το PRE μετράει πόσο καλά το μοντέλο προσαρμόζεται στα δεδομένα, αλλά δεν λαμβάνει υπόψη πόσο πολύπλοκο είναι το μοντέλο.

Παράδειγμα:

| Μοντέλο | Παράμετροι | PRE | Πολυπλοκότητα |

|---|---|---|---|

| Κενό μοντέλο | 1 | 0% | Πολύ απλό |

| Height2Group | 2 | 7% | Απλό |

| Height3Group | 3 | 14% | Μέτρια |

| Height10Group | 10 | 25% | Πολύ πολύπλοκο |

| Ατομικό μοντέλο | 157 | 100% | Άχρηστα πολύπλοκο! |

Το πρόβλημα:

Αν συνεχίσουμε να προσθέτουμε παραμέτρους:

Το PRE θα συνεχίσει να αυξάνεται

Τελικά θα φτάσουμε σε 100% PRE (τέλεια προσαρμογή)

Αλλά το μοντέλο θα είναι υπερπροσαρμοσμένο (overfitted)

Δεν θα γενικεύεται σε νέα δεδομένα

Το PRE ΔΕΝ δείχνει:

Αν η βελτίωση στην προσαρμογή αξίζει την προσθήκη πολυπλοκότητας

Αν το μοντέλο θα λειτουργήσει καλά σε νέα δεδομένα

Αν έχουμε την καλύτερη ισορροπία μεταξύ απλότητας και ακρίβειας

Γιατί οι άλλες είναι λάθος:

Α. “Τέλειο στατιστικό” - ΛΑΘΟΣ

Κανένα στατιστικό δεν είναι τέλειο

Το PRE έχει σημαντικό μειονέκτημα: αγνοεί την πολυπλοκότητα

Β. “Δεν δείχνει πόσο σφάλμα μειώθηκε σε σχέση με το συνολικό” - ΛΑΘΟΣ

- Αυτό είναι ακριβώς αυτό που κάνει το PRE!

\[\text{PRE} = \frac{\text{SS}_{\text{Model}}}{\text{SS}_{\text{Total}}} = \frac{\text{Μείωση σφάλματος}}{\text{Συνολικό σφάλμα}}\]

- Π.χ., PRE = 0.14 σημαίνει ότι μειώσαμε το 14% του συνολικού σφάλματος

Γ. “Ένα από πολλά μέτρα” - ΜΕΡΙΚΩΣ ΣΩΣΤΟ αλλά όχι το χειρότερο

Ναι, υπάρχουν και άλλα μέτρα (AIC, BIC, Adjusted R², κλπ.)

Αλλά αυτό δεν είναι μειονέκτημα του PRE

Είναι καλό να έχουμε πολλά μέτρα!

Το πραγματικό πρόβλημα είναι η αγνόηση της πολυπλοκότητας

Παράδειγμα του προβλήματος:

Φανταστείτε ότι συγκρίνουμε:

Μοντέλο Α: 3 παράμετροι, PRE = 14%

Μοντέλο Β: 50 παράμετροι, PRE = 18%

Το PRE δείχνει ότι το Β είναι καλύτερο (18% > 14%).

Αλλά:

Το Β προσθέτει 47 επιπλέον παραμέτρους για μόνο 4% βελτίωση

Αξίζει την πολυπλοκότητα;

Το PRE δεν μας το δείχνει!

Λύσεις - Μέτρα που λαμβάνουν υπόψη την πολυπλοκότητα:

-

Adjusted R² (Διορθωμένο R²)

“Τιμωρεί” μοντέλα με πολλές παραμέτρους

Αυξάνεται μόνο αν η νέα παράμετρος βελτιώνει αρκετά την προσαρμογή

-

AIC (Akaike Information Criterion)

Ισορροπεί καλή προσαρμογή με απλότητα

Μικρότερο AIC = καλύτερο μοντέλο

-

BIC (Bayesian Information Criterion)

- Παρόμοιο με AIC αλλά “τιμωρεί” περισσότερο την πολυπλοκότητα

Συμπέρασμα:

Το μειονέκτημα του PRE είναι ότι:

Δε λαμβάνει υπόψη την πολυπλοκότητα του μοντέλου

Αυτό σημαίνει ότι:

Μπορεί να μας οδηγήσει σε υπερβολικά πολύπλοκα μοντέλα

Δεν μας βοηθά να βρούμε την καλύτερη ισορροπία μεταξύ απλότητας και ακρίβειας

Πρέπει να το χρησιμοποιούμε μαζί με άλλα μέτρα που λαμβάνουν υπόψη την πολυπλοκότητα

Για αυτό το λόγο:

Χρησιμοποιούμε το PRE για να κατανοήσουμε την ποσότητα της μεταβλητότητας που εξηγεί ένα μοντέλο, αλλά δεν μπορούμε να βασιστούμε σε αυτό για να επιλέξουμε μεταξύ μοντέλων διαφορετικής πολυπλοκότητας.

9.4 Το πηλίκο F

Στην προηγούμενη ενότητα συζητήσαμε τους περιορισμούς του PRE ως μέτρου προσαρμογής ενός μοντέλου. Ένα μοντέλο μπορεί να «υπερπροσαρμοστεί» αν προσθέσουμε υπερβολικά πολλές παραμέτρους, γεγονός που μειώνει μεν το σφάλμα, αλλά εις βάρος της γενικευσιμότητας. Το PRE, επομένως, από μόνο του δεν επαρκεί για να αξιολογήσουμε ουσιαστικά τη βελτίωση της προσαρμογής· μας δείχνει αν το σφάλμα μειώνεται, αλλά όχι με ποιο κόστος επιτυγχάνεται αυτή η μείωση.

Το πηλίκο F (F ratio) έρχεται να καλύψει αυτό το κενό, καθώς προσφέρει έναν δείκτη της μείωσης του σφάλματος που επιτυγχάνεται από ένα μοντέλο, λαμβάνοντας υπόψη τον αριθμό των παραμέτρων που απαιτήθηκαν για αυτή τη μείωση.

Για να κατανοήσουμε πώς υπολογίζεται το πηλίκο F, ας επιστρέψουμε στον πίνακα ANOVA για το μοντέλο Height2Group (που φαίνεται παρακάτω). Έχουμε ήδη εξηγήσει πώς ερμηνεύεται η στήλη SS. Τώρα, ας εξετάσουμε τις επόμενες τρεις στήλες: df, MS και F. Το df αναφέρεται στους βαθμούς ελευθερίας (degrees of freedom), το MS αντιστοιχεί στο Μέσο Άθροισμα Τετραγώνων (Mean Square), και το F είναι, φυσικά, το πηλίκο F.

Analysis of Variance Table (Type III SS)

Model: Thumb ~ Height2Group

SS df MS F PRE p

----- --------------- | --------- --- ------- ------ ------ -----

Model (error reduced) | 830.880 1 830.880 11.656 0.0699 .0008

Error (from model) | 11049.331 155 71.286

----- --------------- | --------- --- ------- ------ ------ -----

Total (empty model) | 11880.211 156 76.155Βαθμοί Ελευθερίας (df)

Τεχνικά, οι βαθμοί ελευθερίας είναι ο αριθμός των ανεξάρτητων πληροφοριών που χρησιμοποιούνται για τον υπολογισμό μιας εκτίμησης παραμέτρου (π.χ., των \(b_0\) ή \(b_1\)). Ωστόσο, είναι συχνά πιο διαισθητικό να τους σκεφτόμαστε ως ένα «απόθεμα» (budget) που έχουμε στη διάθεσή μας. Όσο περισσότερες παρατηρήσεις διαθέτουμε (δηλαδή όσο μεγαλύτερο είναι το μέγεθος του δείγματος, \(n\)), τόσο περισσότερους βαθμούς ελευθερίας έχουμε για να εκτιμήσουμε περισσότερες παραμέτρους — με άλλα λόγια, για να δημιουργήσουμε πιο σύνθετα μοντέλα.

Στο σύνολο δεδομένων Fingers υπάρχουν 157 παρατηρήσεις (φοιτητές). Όταν εκτιμήσαμε τη μοναδική παράμετρο του κενού μοντέλου (την εκτίμηση \(b_0\)), χρησιμοποιήσαμε 1 βαθμό ελευθερίας (1 df), αφήνοντας 156 βαθμούς ελευθερίας διαθέσιμους — αυτό το σύνολο ονομάζεται df Total.

Το μοντέλο της Height2Group απαιτούσε την εκτίμηση μίας επιπλέον παραμέτρου (της εκτίμησης \(b_1\)), γεγονός που μας «κόστισε» έναν ακόμη βαθμό ελευθερίας. Γι’ αυτό, στον πίνακα ANOVA (γραμμή Model (error reduced)), βλέπουμε ότι το df Model είναι 1. Μετά την προσαρμογή του μοντέλου της Height2Group, απομένουν 155 βαθμοί ελευθερίας, οι οποίοι αντιστοιχούν στο df Error.

Κάθε επιπλέον παράμετρος σε ένα μοντέλο κοστίζει:

Σωστή απάντηση: Β - έναν επιπλέον βαθμό ελευθερίας

Τι είναι οι βαθμοί ελευθερίας;

Οι βαθμοί ελευθερίας είναι ο αριθμός των “ανεξάρτητων κομματιών πληροφορίας” που απομένουν μετά την εκτίμηση των παραμέτρων ενός μοντέλου.

Τύπος:

\[\text{df}_{\text{Error}} = n - k\]

όπου:

\(n\) = αριθμός παρατηρήσεων (άτομα)

\(k\) = αριθμός παραμέτρων στο μοντέλο

Παραδείγματα από τα μοντέλα μας:

| Μοντέλο | Παράμετροι \((k)\) | Παρατηρήσεις \((n)\) | df Error |

|---|---|---|---|

| Κενό μοντέλο | 1 (\(b_0\)) | 157 | \(157 - 1 = 156\) |

| Height2Group | 2 (\(b_0, b_1\)) | 157 | \(157 - 2 = 155\) |

| Height3Group | 3 (\(b_0, b_1, b_2\)) | 157 | \(157 - 3 = 154\) |

Από τον πίνακα ANOVA:

Height2Group:

Error (from model) | 11049.331 155 71.286

^^^ df = 155

Height3Group:

Error (from model) | 10189.770 154 66.167

^^^ df = 154Γιατί «κοστίζει» βαθμούς ελευθερίας;

Κάθε παράμετρος που εκτιμούμε:

-

“Χρησιμοποιεί” ένα μέρος των δεδομένων

Για να εκτιμήσουμε το \(b_0\), χρειαζόμαστε δεδομένα

Για να εκτιμήσουμε το \(b_1\), χρειαζόμαστε περισσότερα δεδομένα

κλπ.

-

Μειώνει την “ελευθερία” των υπολοίπων

Με περισσότερες παραμέτρους, τα υπόλοιπα έχουν λιγότερη ελευθερία να διαφέρουν

Το μοντέλο είναι πιο “περιορισμένο”

-

Επηρεάζει την ακρίβεια της εκτίμησης

- Με λιγότερους df, οι εκτιμήσεις μας είναι λιγότερο ακριβείς

Γιατί οι άλλες είναι λάθος:

Α. “Επιπλέον σύνολο δεδομένων” - ΛΑΘΟΣ

Οι παράμετροι δεν χρειάζονται νέα δεδομένα

Χρησιμοποιούμε το ίδιο σύνολο δεδομένων για όλες τις παραμέτρους

Π.χ., Τα μοντέλα των Height2Group και Height3Group χρησιμοποιούν τα ίδια 157 άτομα

Γ. “Μια μεταβλητή” - ΛΑΘΟΣ

- Οι παράμετροι και οι μεταβλητές είναι διαφορετικά πράγματα

Παράμετροι: - Σταθερές τιμές που εκτιμούμε (\(b_0, b_1, b_2\))

- Οι ίδιες για όλα τα άτομα

Μεταβλητές: - Δεδομένα που διαφέρουν ανά άτομο (\(Y_i, X_{1i}, X_{2i}\))

- Έχουν δείκτη \(i\)

Π.χ., στο μοντέλο της Height3Group:

3 παράμετροι: \(b_0, b_1, b_2\)

3 μεταβλητές: \(Y_i\) (Thumb), \(X_{1i}\) (medium), \(X_{2i}\) (tall)

Αλλά οι παράμετροι κοστίζουν df, όχι μεταβλητές

Αναλυτική παρουσίαση:

Έχουμε 157 άτομα (n = 157)

Κενό μοντέλο: 1 παράμετρος

├─ Χρησιμοποιεί 1 df για το b₀

└─ Απομένουν: 157 - 1 = 156 df

Height2Group: 2 παράμετροι

├─ Χρησιμοποιεί 1 df για το b₀

├─ Χρησιμοποιεί 1 df για το b₁

└─ Απομένουν: 157 - 2 = 155 df

Height3Group: 3 παράμετροι

├─ Χρησιμοποιεί 1 df για το b₀

├─ Χρησιμοποιεί 1 df για το b₁

├─ Χρησιμοποιεί 1 df για το b₂

└─ Απομένουν: 157 - 3 = 154 df

Κάθε παράμετρος κοστίζει 1 df!Συμπέρασμα:

Κάθε επιπλέον παράμετρος σε ένα μοντέλο κοστίζει έναν βαθμό ελευθερίας.

Για αυτό λέμε ότι η εκτίμηση επιπλέον παραμέτρων δεν είναι δωρεάν - έχει «κόστος» σε βαθμούς ελευθερίας!

Μέσα Αθροίσματα Τετραγώνων (MS)

Η στήλη με τίτλο MS, γνωστή και ως στήλη των διακυμάνσεων, περιέχει τα μέσα αθροίσματα τετραγώνων.

Analysis of Variance Table (Type III SS)

Model: Thumb ~ Height2Group

SS df MS F PRE p

----- --------------- | --------- --- ------- ------ ------ -----

Model (error reduced) | 830.880 1 830.880 11.656 0.0699 .0008

Error (from model) | 11049.331 155 71.286

----- --------------- | --------- --- ------- ------ ------ -----

Total (empty model) | 11880.211 156 76.155Κάθε τιμή MS υπολογίζεται διαιρώντας το άθροισμα τετραγώνων (SS) με τους αντίστοιχους βαθμούς ελευθερίας (df) για κάθε γραμμή του πίνακα.

\[\begin{align} \text{MS}_{\text{Model}} &= \frac{\text{SS}_{\text{Model}}}{\text{df}_{\text{Model}}} \\ \text{MS}_{\text{Error}} &= \frac{\text{SS}_{\text{Error}}}{\text{df}_{\text{Error}}} \\ \text{MS}_{\text{Total}} &= \frac{\text{SS}_{\text{Total}}}{\text{df}_{\text{Total}}} \end{align}\]

Ξεκινώντας από την τελευταία γραμμή, το MS Total δείχνει πόσο συνολικό σφάλμα υπάρχει στην εξαρτημένη μεταβλητή ανά βαθμό ελευθερίας, μετά την προσαρμογή του κενού μοντέλου. Αυτό, σε προηγούμενο κεφάλαιο, το ονομάσαμε διακύμανση της εξαρτημένης μεταβλητής. Το MS Error δείχνει πόσο σφάλμα παραμένει ανεξήγητο ανά βαθμό ελευθερίας, μετά την προσαρμογή του μοντέλου της Height2Group. Το MS Model εκφράζει τη μείωση του σφάλματος που πέτυχε το μοντέλο ανά βαθμό ελευθερίας που χρησιμοποιήθηκε πέρα από το κενό μοντέλο.

Ποιο από τα παρακάτω μέσα αθροίσματα τετραγώνων (MS) εκφράζει το συνολικό σφάλμα που υπολείπεται από το κενό μοντέλο ανά βαθμό ελευθερίας;

Σωστή απάντηση: Γ - MS Total

Τι είναι το MS Total;

\[\text{MS}_{\text{Total}} = \frac{\text{SS}_{\text{Total}}}{\text{df}_{\text{Total}}}\]

Από τον πίνακα ANOVA:

\[\text{MS}_{\text{Total}} = \frac{11880.211}{156} = 76.155\]

Τι σημαίνει αυτό;

Το MS Total είναι το συνολικό σφάλμα από το κενό μοντέλο, διαιρεμένο με τους βαθμούς ελευθερίας που υπολείπονται στο κενό μοντέλο.

Αναλυτικά:

-

SS\(_{\text{Total}}\) = 11880.211

Η συνολική μεταβλητότητα του μήκους αντίχειρα

Το σφάλμα από το κενό μοντέλο (που προβλέπει μόνο το γενικό μέσο όρο)

\[\text{SS}_{\text{Total}} = \sum_{i=1}^{n}(Y_i - \bar{Y})^2\]

-

df\(_{\text{Total}}\) = 156

Οι βαθμοί ελευθερίας του κενού μοντέλου

\[\text{df}_{\text{Total}} = n - 1 = 157 - 1 = 156\]

Χάνουμε 1 df επειδή εκτιμούμε το γενικό μέσο όρο (\(\bar{Y}\) ή \(b_0\))

-

MS\(_{\text{Total}}\) = 76.155

Το μέσο σφάλμα ανά βαθμό ελευθερίας

Πόσο σφάλμα έχουμε “κατά μέσο όρο” όταν χρησιμοποιούμε μόνο το γενικό μέσο όρο

Γιατί οι άλλες είναι λάθος:

Α. “MS Model” - ΛΑΘΟΣ

\[\text{MS}_{\text{Model}} = \frac{\text{SS}_{\text{Model}}}{\text{df}_{\text{Model}}} = \frac{830.880}{1} = 830.880\]

Αυτό αντιπροσωπεύει τη μεταβλητότητα που εξηγείται από το μοντέλο

Όχι το σφάλμα από το κενό μοντέλο

df\(_{\text{Model}}\) = 1 (αριθμός ψευδομεταβλητών: \(X_1\) για tall)

Β. “MS Error” - ΛΑΘΟΣ

\[\text{MS}_{\text{Error}} = \frac{\text{SS}_{\text{Error}}}{\text{df}_{\text{Error}}} = \frac{11049.331}{155} = 71.286\]

Αυτό αντιπροσωπεύει το σφάλμα που υπολείπεται μετά την προσαρμογή του μοντέλου της Height2Group

Όχι το σφάλμα από το κενό μοντέλο

df\(_{\text{Error}}\) = 155 = 157 - 2 (χάσαμε 2 df για τις 2 παραμέτρους: \(b_0, b_1\))

Σύγκριση των τριών MS:

| Μέτρο | Τύπος | Τιμή | Ερμηνεία |

|---|---|---|---|

| MS Total | \(\frac{SS_{Total}}{df_{Total}}\) | \(\frac{11880.2}{156} = 76.155\) | Μέσο σφάλμα από κενό μοντέλο |

| MS Model | \(\frac{SS_{Model}}{df_{Model}}\) | \(\frac{830.9}{1} = 830.880\) | Μέση εξηγούμενη μεταβλητότητα |

| MS Error | \(\frac{SS_{Error}}{df_{Error}}\) | \(\frac{11049.3}{155} = 71.286\) | Μέσο σφάλμα από Height2Group |

Παρατηρήσεις:

-

MS Total(76.155) >MS Error(71.286)Το μοντέλο της

Height2Groupμείωσε το μέσο σφάλμα!Από 76.155 → 71.286 mm²

MS Model(830.880) >>MS Error(71.286)

Γιατί είναι σημαντικό το MS Total;

-

Βάση για σύγκριση:

Δείχνει πόσο σφάλμα έχουμε χωρίς μοντέλο

Συγκρίνουμε το

MS Errorμε τοMS Totalγια να δούμε τη βελτίωση

-

Υπολογισμός του PRE:

Μπορούμε να εκφράσουμε το PRE χρησιμοποιώντας το

MS:Η μείωση από 76.155 → 71.286 αντιπροσωπεύει τη βελτίωση

-

Κατανόηση της βελτίωσης:

MS Total= 76.155 mm² (ξεκινώντας)MS Error= 71.286 mm² (μετά το μοντέλο)Βελτίωση: \(76.155 - 71.286 = 4.869\) mm² ανά

df

Συμπέρασμα:

Το MS Total αντιπροσωπεύει το συνολικό σφάλμα από το κενό μοντέλο ανά βαθμό ελευθερίας. Είναι το σημείο αναφοράς που δείχνει πόσο σφάλμα έχουμε όταν δεν χρησιμοποιούμε καμία ανεξάρτητη μεταβλητή - απλά προβλέπουμε το γενικό μέσο όρο για όλους.

Ποιο από τα μέσα αθροίσματα τετραγώνων (MS) εκφράζει το σφάλμα που υπολείπεται από το σύνθετο μοντέλο ανά βαθμό ελευθερίας;

Σωστή απάντηση: Β - MS Error

Τι είναι το MS Error;

\[\text{MS}_{\text{Error}} = \frac{\text{SS}_{\text{Error}}}{\text{df}_{\text{Error}}}\]

Από τον πίνακα ANOVA:

\[\text{MS}_{\text{Error}} = \frac{11049.331}{155} = 71.286\]

Τι σημαίνει αυτό;

Το MS Error είναι το σφάλμα που απομένει από το σύνθετο μοντέλο (της Height2Group), διαιρεμένο με τους βαθμούς ελευθερίας που απομένουν μετά την εκτίμηση των παραμέτρων του μοντέλου.

Αναλυτικά:

-

SS\(_{\text{Error}}\) = 11049.331

Η μεταβλητότητα που δεν εξηγείται από το μοντέλο της

Height2GroupΤο άθροισμα των τετραγώνων των υπολοίπων:

\[\text{SS}_{\text{Error}} = \sum_{i=1}^{n}(Y_i - \hat{Y}_i)^2\]

-

df\(_{\text{Error}}\) = 155

Οι βαθμοί ελευθερίας που απομένουν μετά την προσαρμογή του μοντέλου

\[\text{df}_{\text{Error}} = n - k = 157 - 2 = 155\]

Χάσαμε 2 df για τις 2 παραμέτρους: \(b_0, b_1\)

-

MS\(_{\text{Error}}\) = 71.286

Το μέσο σφάλμα ανά βαθμό ελευθερίας από το σύνθετο μοντέλο

Πόσο σφάλμα απομένει “κατά μέσο όρο” μετά την εξήγηση από το μοντέλο της

Height2Group

Γιατί λέγεται “σφάλμα από το σύνθετο μοντέλο”;

Το σύνθετο μοντέλο είναι:

\[\text{Thumb}_i = b_0 + b_1X_{1i} + e_i\]

όπου \(X_1\) = 1 αν το άτομο είναι tall, 0 αν είναι short.

Το σφάλμα από το σύνθετο μοντέλο είναι το \(e_i\) - η μεταβλητότητα που δεν μπόρεσε να εξηγήσει το μοντέλο.

Γιατί οι άλλες είναι λάθος:

Α. MS Model - ΛΑΘΟΣ

\[\text{MS}_{\text{Model}} = \frac{\text{SS}_{\text{Model}}}{\text{df}_{\text{Model}}} = \frac{830.880}{1} = 830.880\]

Αυτό αντιπροσωπεύει τη μεταβλητότητα που ΕΞΗΓΕΙΤΑΙ από το μοντέλο

Όχι το σφάλμα που απομένει

Μετράει την επιτυχία του μοντέλου, όχι το σφάλμα του

Γ. MS Total - ΛΑΘΟΣ

\[\text{MS}_{\text{Total}} = \frac{\text{SS}_{\text{Total}}}{\text{df}_{\text{Total}}} = \frac{11880.211}{156} = 76.155\]

Αυτό αντιπροσωπεύει το σφάλμα από το ΚΕΝΟ μοντέλο

Όχι από το σύνθετο μοντέλο (της

Height2Group)Είναι το σημείο αναφοράς πριν προσθέσουμε ανεξάρτητες μεταβλητές

Σύγκριση των τριών MS:

| Μέτρο | Τύπος | Τιμή | Τι αντιπροσωπεύει |

|---|---|---|---|

| MS Total | \(\frac{SS_{Total}}{df_{Total}}\) | \(\frac{11880.2}{156} = 76.155\) | Σφάλμα από κενό μοντέλο |

| MS Error | \(\frac{SS_{Error}}{df_{Error}}\) | \(\frac{11049.3}{155} = 71.286\) | Σφάλμα από σύνθετο μοντέλο |

| MS Model | \(\frac{SS_{Model}}{df_{Model}}\) | \(\frac{830.9}{1} = 830.880\) | Μεταβλητότητα που εξηγείται |

Πιο αναλυτικά:

ΔΙΑΔΙΚΑΣΙΑ ΜΟΝΤΕΛΟΠΟΙΗΣΗΣ:

Βήμα 1: ΚΕΝΟ ΜΟΝΤΕΛΟ

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

SS_Total = 11880.2 mm²

MS_Total = 76.155 mm²/df

(Όλο σφάλμα)

Βήμα 2: ΠΡΟΣΘΕΤΟΥΜΕ ΤΗΝ HEIGHT2GROUP

┌─────────────────┬──────────────────────────┐

│ ΕΞΗΓΕΙΤΑΙ │ ΑΠΟΜΕΝΕΙ (ΣΦΑΛΜΑ) │

│ SS_Model │ SS_Error ← Αυτό! │

│ 830.9 │ 11049.3 │

│ MS = 830.880 │ MS = 71.286 ← Αυτό! │

│ │ (Σφάλμα από σύνθετο) │

└─────────────────┴──────────────────────────┘

Το MS Error (71.286) είναι το μέσο σφάλμα

που ΑΠΟΜΕΝΕΙ μετά το μοντέλο της `Height2Group`Η βελτίωση:

Πριν το μοντέλο: MS Total = 76.155 mm²/df

Μετά το μοντέλο: MS Error = 71.286 mm²/df

Μείωση: 76.155 - 71.286 = 4.869 mm²/df (6.4% μείωση)

Γιατί είναι σημαντικό το MS Error;

-

Μετράει την ποιότητα του μοντέλου:

Μικρότερο

MS Error= καλύτερο μοντέλοΛιγότερο σφάλμα ανά βαθμό ελευθερίας

-

Χρησιμοποιείται για στατιστικούς ελέγχους:

- Θα τους δούμε σε επόμενο κεφάλαιο

-

Εκτίμηση της διακύμανσης:

Το

MS Errorεκτιμά τη διακύμανση \(\sigma^2\) των υπολοίπωνΧρησιμοποιείται για να υπολογίσουμε τυπικά σφάλματα (θα τα δούμε σε επόμενο κεφάλαιο)

Σύγκριση μοντέλων:

| Μοντέλο | MS Error |

Ερμηνεία |

|---|---|---|

| Κενό | 76.155 | Αρχικό σφάλμα ανά df

|

Height2Group |

71.286 | Λιγότερο |

Παράδειγμα ερμηνείας:

Το MS Error = 71.286 mm² σημαίνει:

«Μετά την προσαρμογή του μοντέλου, το μέσο τετραγωνικό σφάλμα που απομένει είναι 71.286 mm². Αυτό σημαίνει ότι οι προβλέψεις μας έχουν τυπική απόκλιση περίπου \(\sqrt{71.286} \approx 8.44\) mm.»

Συμπέρασμα:

Το MS Error αντιπροσωπεύει το σφάλμα που απομένει από το σύνθετο μοντέλο (Height2Group) ανά βαθμό ελευθερίας. Μετράει πόσο σφάλμα δεν μπόρεσε να εξηγήσει το μοντέλο - αυτό που παραμένει ακόμα και μετά την προσθήκη της ανεξάρτητης μεταβλητής.

Ποιο από αυτά τα μέσα αθροίσματα τετραγώνων (MS) εκφράζει το σφάλμα που μειώθηκε από το σύνθετο μοντέλο ανά βαθμό ελευθερίας που δαπανήθηκε;

Σωστή απάντηση: Α - MS Model

Τι είναι το MS Model;

\[\text{MS}_{\text{Model}} = \frac{\text{SS}_{\text{Model}}}{\text{df}_{\text{Model}}}\]

Από τον πίνακα ANOVA:

\[\text{MS}_{\text{Model}} = \frac{830.880}{1} = 830.880\]

Τι σημαίνει αυτό;

Το MS Model αντιπροσωπεύει το σφάλμα που μειώθηκε (ή τη μεταβλητότητα που εξηγήθηκε) από το σύνθετο μοντέλο, διαιρεμένο με τους βαθμούς ελευθερίας που δαπανήθηκαν για να επιτευχθεί αυτή η μείωση.

Αναλυτικά:

-

SS\(_{\text{Model}}\) = 830.880

Το σφάλμα που μειώθηκε από το κενό μοντέλο

Η μεταβλητότητα που εξηγήθηκε από το μοντέλο της

Height2Group\[\text{SS}_{\text{Model}} = \text{SS}_{\text{Total}} - \text{SS}_{\text{Error}}\]

\[830.880 = 11880.211 - 11049.331\]

-

df\(_{\text{Model}}\) = 1

Οι βαθμοί ελευθερίας που δαπανήθηκαν για το μοντέλο

Αριθμός ψευδομεταβλητών (ανεξάρτητων μεταβλητών)

2 ομάδες → 1 ψευδομεταβλητή (\(X_1\) για

tall)Όχι 2, επειδή η ομάδα αναφοράς (

short) δεν χρειάζεται ψευδομεταβλητή

-

MS\(_{\text{Model}}\) = 830.880

Το μέσο σφάλμα που μειώθηκε ανά

dfπου δαπανήθηκεΠόσο σφάλμα μειώσαμε “κατά μέσο όρο” για κάθε παράμετρο που προσθέσαμε

Γιατί οι άλλες είναι λάθος:

Β. MS Error - ΛΑΘΟΣ

\[\text{MS}_{\text{Error}} = \frac{11049.331}{155} = 71.286\]

Αυτό αντιπροσωπεύει το σφάλμα που ΑΠΟΜΕΝΕΙ (όχι που μειώθηκε)

Είναι η ανεξήγητη μεταβλητότητα, όχι η εξηγούμενη

Γ. MS Total - ΛΑΘΟΣ

\[\text{MS}_{\text{Total}} = \frac{11880.211}{156} = 76.155\]

Αυτό αντιπροσωπεύει το συνολικό σφάλμα από το κενό μοντέλο

Δεν μετράει τη μείωση που επιτεύχθηκε από το σύνθετο μοντέλο

Η έννοια του “σφάλματος που μειώθηκε ανά df που δαπανήθηκε”:

ΚΕΝΟ ΜΟΝΤΕΛΟ:

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

SS_Total = 11880.2

(Όλο σφάλμα)

ΠΡΟΣΘΕΤΟΥΜΕ ΤΗΝ HEIGHT2GROUP:

Δαπανούμε 1 df (για X₁)

┌─────────────────┬──────────────────────────┐

│ ΜΕΙΩΣΗ ΣΦΑΛΜΑΤΟΣ│ ΥΠΟΛΟΙΠΟΜΕΝΟ ΣΦΑΛΜΑ │

│ SS_Model │ SS_Error │

│ 830.9 │ 11049.3 │

│ │ │

│ Δαπανήθηκε 1 df │ Απομένουν 155 df │

│ │ │

│ MS = 830.9/1 │ MS = 11049.3/155 │

│ = 830.880 ←──┼─ Αυτό! │

│ │ = 71.286 │

└─────────────────┴──────────────────────────┘

MS Model = Πόσο σφάλμα μειώσαμε κατά μέσο όρο

ανά παράμετρο που προσθέσαμεΕρμηνεία:

Το MS Model = 830.880 mm² σημαίνει:

«Για τον έναν βαθμό ελευθερίας που δαπανήσαμε (την παράμετρο που προσθέσαμε), μειώσαμε το σφάλμα κατά 830.880 mm².»

Δαπανήσαμε 1 df (για \(b_1\))

Μειώσαμε συνολικά 830.9 mm² σφάλμα

Κατά μέσο όρο: 830.9 mm² ανά

df

Σύγκριση των τριών MS:

| Μέτρο | Τύπος | Τιμή | Τι μετράει |

|---|---|---|---|

MS Total |

\(\frac{SS_{Total}}{df_{Total}}\) | \(\frac{11880.2}{156} = 76.155\) | Συνολικό σφάλμα (ανά df) πριν το μοντέλο |

MS Model |

\(\frac{SS_{Model}}{df_{Model}}\) | \(\frac{830.9}{1} = 830.880\) | Σφάλμα που μειώθηκε (ανά δαπανηθέν df) |

MS Error |

\(\frac{SS_{Error}}{df_{Error}}\) | \(\frac{11049.3}{155} = 71.286\) | Σφάλμα που απομένει (ανά df που απομένει) |

Γιατί είναι σημαντικό το MS Model;

-

Μετράει την αποδοτικότητα του μοντέλου:

Μεγάλο

MS Model= πολύ σφάλμα μειώθηκε ανά παράμετροΔείχνει ότι η παράμετρος “άξιζε” την επιπλέον πολυπλοκότητα

-

Αξιολόγηση κόστους-οφέλους:

Κόστος: 1 df δαπανήθηκε

Όφελος: 830.9 mm² μείωση ανά

dfΑξίζει; Ναι! Το

MS Model>>MS Error

Οπτικοποίηση της έννοιας:

"Πόσο σφάλμα μειώνουμε ανά παράμετρο;"

Κάθε παράμετρος (df) "αγοράζει" μείωση σφάλματος:

Παράμετρος 1 (b₁): ┌────────────┐

│ 830.9 mm² │

│ μείωση │

└────────────┘

Σύνολο: 1 df × 830.9 = 830.9 mm² (SS_Model)

Μέσος όρος: 830.9 mm²/df (MS_Model)Συμπέρασμα:

Το MS Model αντιπροσωπεύει το σφάλμα που μειώθηκε από το σύνθετο μοντέλο ανά βαθμό ελευθερίας που δαπανήθηκε. Είναι μέτρο της αποδοτικότητας του μοντέλου - πόσο σφάλμα εξηγούμε κατά μέσο όρο για κάθε παράμετρο που προσθέτουμε. Μεγάλο MS Model σημαίνει ότι η παράμετρος “άξιζε” την πολυπλοκότητα που πρόσθεσε.

Το πηλίκο F

Ας περάσουμε τώρα στο πηλίκο F. Στον πίνακα που ακολουθεί παρουσιάζονται δύο διαφορετικές εκτιμήσεις διακύμανσης μετά την προσαρμογή του μοντέλου της Height2Group: το MS Model και το MS Error.

SS df MS F PRE p

----- --------------- | --------- --- ------- ------ ------ -----

Model (error reduced) | 830.880 1 830.880 11.656 0.0699 .0008

Error (from model) | 11049.331 155 71.286

----- --------------- | --------- --- ------- ------ ------ -----

Total (empty model) | 11880.211 156 76.155 Το MS Model εκφράζει τη διακύμανση των προβλέψεων που παράγει το μοντέλο της Height2Group, ενώ το MS Error εκφράζει τη διακύμανση των υπολοίπων —δηλαδή του σφάλματος που υπολείπεται αφού αφαιρεθεί το μοντέλο.

Το πηλίκο F υπολογίζεται ως ο λόγος αυτών των δύο ποσοτήτων:

\[F = \frac{\text{MS}_{\text{Model}}}{\text{MS}_{\text{Error}}} = \frac{\text{SS}_{\text{Model}}/\text{df}_{\text{Model}}}{\text{SS}_{\text{Error}}/\text{df}_{\text{Error}}}\]

Αυτός ο λόγος αποτελεί έναν εξαιρετικά χρήσιμο στατιστικό δείκτη.

Αν η μεταβλητή Height2Group έχει μικρή ή καθόλου επίδραση στο μήκος του αντίχειρα, τότε η διακύμανση των προβλέψεων του μοντέλου θα είναι περίπου ίση με τη διακύμανση των υπολοίπων, οπότε το πηλίκο F θα είναι κοντά στη μονάδα. Αντίθετα, όσο μεγαλύτερη είναι η διακύμανση των προβλέψεων σε σχέση με τη διακύμανση των υπολοίπων, τόσο μεγαλύτερο θα είναι το πηλίκο F και τόσο καλύτερη θεωρείται η προσαρμογή του μοντέλου.

Ένας άλλος τρόπος να το σκεφτούμε είναι ότι το F εκφράζει τον λόγο της διακύμανσης μεταξύ των ομάδων (καθώς οι μέσοι όροι των ομάδων αντιστοιχούν στις προβλέψεις του μοντέλου) προς τη διακύμανση εντός των ομάδων (δηλαδή τη διασπορά των παρατηρήσεων γύρω από τους μέσους όρους). Όταν η διακύμανση μεταξύ των ομάδων είναι σημαντικά μεγαλύτερη από τη διακύμανση εντός των ομάδων, το πηλίκο F υπερβαίνει τη μονάδα —υποδεικνύοντας ότι το μοντέλο εξηγεί ουσιαστικό μέρος της συνολικής μεταβλητότητας.

Το πηλίκο F για το μοντέλο της Height2Group είναι 11.66. Ποια είναι η σωστή ερμηνεία;

Σωστή απάντηση: Γ - Η διακύμανση που εξηγείται είναι 11.66 φορές μεγαλύτερη από τη διακύμανση που παραμένει ανεξήγητη

Τι είναι το πηλίκο F;

Το πηλίκο F είναι ο λόγος δύο διακυμάνσεων:

\[F = \frac{\text{MS}_{\text{Model}}}{\text{MS}_{\text{Error}}}\]

Από τον πίνακα ANOVA:

\[F = \frac{830.880}{71.286} = 11.656 \approx 11.66\]

Τι δείχνει το F;

Το F συγκρίνει:

Αριθμητής (

MS Model): Πόσο καλά το μοντέλο εξηγεί τη μεταβλητότητα (ανά βαθμό ελευθερίας)Παρονομαστής (

MS Error): Πόση μεταβλητότητα παραμένει ανεξήγητη (ανά βαθμό ελευθερίας)

Με απλά λόγια:

\[F = \frac{\text{Πόσο καλά δουλεύει το μοντέλο}}{\text{Πόσο σφάλμα απομένει}}\]

Ερμηνεία του F = 11.66:

«Η μεταβλητότητα που εξηγείται από την

Height2Group(ανά βαθμό ελευθερίας) είναι 11.66 φορές μεγαλύτερη από τη μεταβλητότητα που παραμένει ανεξήγητη (ανά βαθμό ελευθερίας).»

«Η διακύμανση που εξηγείται από την

Height2Groupείναι 11.66 φορές μεγαλύτερη από τη διακύμανση που οφείλεται σε τυχαίο θόρυβο.»

Γιατί οι άλλες είναι λάθος:

Α. “11 άτομα προβλέπονται καλύτερα” - ΛΑΘΟΣ

Το

Fδεν μετράει αριθμό ατόμωνΕίναι ένας λόγος διακυμάνσεων (χωρίς μονάδες μέτρησης)

Το μοντέλο δίνει προβλέψεις για όλα τα άτομα, όχι μόνο για 11

Β. “Μέγεθος επίδρασης 11.66 τυπικές αποκλίσεις” - ΛΑΘΟΣ

Το

Fδεν είναι μέγεθος επίδρασης σε τυπικές αποκλίσειςΤο

Fείναι χωρίς μονάδεςΓια το μέγεθος επίδρασης μπορούμε να χρησιμοποιήσουμε το d του Cohen (βλ. επόμενη ενότητα)**

Δ. Το “SS Model είναι 11.66 φορές μεγαλύτερο από το SS Error” - ΛΑΘΟΣ

Ας το ελέγξουμε:

\[\frac{\text{SS}_{\text{Model}}}{\text{SS}_{\text{Error}}} = \frac{830.880}{11049.331} = 0.0752\]

Το

SS Modelείναι 0.075 φορές (όχι 11.66 φορές) τοSS ErrorΤο

SS Modelείναι στην πραγματικότητα πολύ μικρότερο από τοSS Error

Το F χρησιμοποιεί MS, όχι SS!

Η διαφορά μεταξύ SS και MS:

| Άθροισμα Τετραγώνων (SS) | Μέσο Τετραγωνικό Σφάλμα (MS) | |

|---|---|---|

| Τύπος | Άθροισμα | Μέσος όρος (ανά df) |

| Model | 830.880 | 830.880 / 1 = 830.880 |

| Error | 11049.331 | 11049.331 / 155 = 71.286 |

| Πηλίκο | 0.075 | 11.66 |

Γιατί η Γ είναι σωστή;

Το MS μετράει διακύμανση:

\[\text{MS} = \frac{\text{SS}}{\text{df}} = \text{μέση μεταβλητότητα ανά βαθμό ελευθερίας}\]

Ο υπολογισμός:

MS_Model = 830.880 / 1 = 830.880

MS_Error = 11049.331 / 155 = 71.286

F = MS_Model / MS_Error

= 830.880 / 71.286

= 11.656

# Ερμηνεία:

# Η εξηγούμενη μεταβλητότητα (ανά `df`) είναι

# 11.66 φορές η ανεξήγητη μεταβλητότητα (ανά `df`)Τι σημαίνει αυτό στην πράξη;

-

Το μοντέλο είναι αποδοτικό:

- Κάθε βαθμός ελευθερίας που δαπανήσαμε (εδώ 1 για το \(b_1\)) εξηγεί 11.66 φορές περισσότερη μεταβλητότητα από όση θα περιμέναμε από τυχαία διακύμανση.

-

Σύγκριση με τυχαίο θόρυβο:

Αν η

Height2Groupδεν είχε καμία πραγματική επίδραση, θα περιμέναμεF≈ 1F= 11.66 >> 1, άρα η επίδραση είναι πολύ μεγαλύτερη από τυχαίες διακυμάνσεις.Όπως θα δούμε σε επόμενο κεφάλαιο, είναι εξαιρετικά απίθανο (πιθανότητα p = .0008) να δούμε τόσο μεγάλο

Fαν η ομάδα ύψους δεν επηρέαζε πραγματικά το μήκος αντίχειρα

Πλήρης ερμηνεία του F = 11.66:

«Το μοντέλο της

Height2Groupεξηγεί 11.66 φορές περισσότερη μεταβλητότητα στο μήκος αντίχειρα (ανά βαθμό ελευθερίας) σε σχέση με τη μεταβλητότητα που παραμένει ανεξήγητη. Αυτό σημαίνει ότι η γνώση της ομάδας ύψους (shortvstall) συμβάλει ουσιαστικά στην πρόβλεψη του μήκους αντίχειρα, πέρα από τον τυχαίο θόρυβο.»

Σύνδεση με άλλα μέτρα:

PRE = 0.0699 (7%): Το μοντέλο εξηγεί 7% της συνολικής μεταβλητότητας

F = 11.66: Η μεταβλητότητα που εξηγείται (ανά

df) είναι 11.66× την ανεξήγητη (ανάdf)

Όλα τα μέτρα μας δείχνουν το ίδιο πράγμα από διαφορετική οπτική: Η Height2Group έχει σημαντική επίδραση!

Συμπέρασμα:

Ένα πηλίκο F = 11.66 σημαίνει ότι η μεταβλητότητα που εξηγείται από το μοντέλο (ανά βαθμό ελευθερίας) είναι 11.66 φορές μεγαλύτερη από τη μεταβλητότητα που απομένει ανεξήγητη (ανά βαθμό ελευθερίας). Αυτό είναι η ουσία του πηλίκου F: συγκρίνει τη μέση εξηγούμενη με τη μέση ανεξήγητη μεταβλητότητα.

Όπως η διακύμανση προσαρμόζει το άθροισμα τετραγώνων (SS) ανάλογα με τους διαθέσιμους βαθμούς ελευθερίας, έτσι και το πηλίκο F λαμβάνει υπόψη του πόσους βαθμούς ελευθερίας «δαπανήσαμε» για να κάνουμε το μοντέλο πιο σύνθετο. Με άλλα λόγια, το F μάς δείχνει αν αυτή η «επένδυση» σε πολυπλοκότητα άξιζε τον κόπο — αν οι πρόσθετες παράμετροι συμβάλλουν ουσιαστικά στην εξήγηση της μεταβλητότητας ή αν απλώς βοηθούν το μοντέλο να προσαρμοστεί καλύτερα στον τυχαίο θόρυβο των δεδομένων.

Αν πάρουμε ένα διαφορετικό δείγμα 157 φοιτητών και τους ζητήσουμε μετρήσεις αντίχειρα και ύψους, θα πάρουμε την ίδια τιμή F;

Σωστή απάντηση: Β - Όχι, κάτι τέτοιο είναι απίθανο

Γιατί δεν θα πάρουμε την ίδια τιμή F;

Το πηλίκο F υπολογίζεται από δεδομένα δείγματος, οπότε εξαρτάται από την τυχαία δειγματοληπτική μεταβλητότητα (sampling variability).

Τι είναι η δειγματοληπτική μεταβλητότητα;

Κάθε φορά που παίρνουμε ένα νέο δείγμα από τον πληθυσμό:

Θα έχουμε διαφορετικά άτομα

Με διαφορετικές τιμές μήκους αντίχειρα και ύψους

Άρα διαφορετικά

SS,MS, καιF

Γιατί συμβαίνει αυτό;

-

Τυχαία δειγματοληψία:

Κάθε δείγμα είναι μια τυχαία επιλογή από τον πληθυσμό

Διαφορετικά δείγματα → διαφορετικοί μέσοι όροι, μεταβλητότητα

-

Μεταβλητότητα στις εκτιμήσεις:

Οι παράμετροι \(b_0, b_1\) αναμένεται να διαφέρουν

Τα υπόλοιπα θα είναι διαφορετικά

Άρα διαφορετικά

SS,MS,F

-

Ατομικές διαφορές:

Κάθε δείγμα θα έχει διαφορετικά άτομα

Μερικά δείγματα μπορεί να έχουν πιο ακραίες τιμές

Άλλα μπορεί να έχουν πιο “συνηθισμένες” τιμές

Οπτικοποίηση:

ΠΛΗΘΥΣΜΟΣ ΦΟΙΤΗΤΩΝ

(Όλοι οι φοιτητές)

│

├─────┬─────┬─────┬─────┐

│ │ │ │ │

Δείγμα Δείγμα Δείγμα ... Δείγμα

1 2 3 ∞

┌────┐ ┌────┐ ┌────┐ ┌────┐

│F= │ │F= │ │F= │ ... │F= │

│11.7│ │10.8│ │12.6│ │ ; │

└────┘ └────┘ └────┘ └────┘

Κάθε δείγμα δίνει διαφορετικό F!Τι ΘΑ είναι παρόμοιο;

Αν και η τιμή του F θα διαφέρει, αναμένουμε:

-

Παρόμοιο μέγεθος

F:Αν το πραγματικό

Fστον πληθυσμό είναι γύρω στο 11-12Τα περισσότερα δείγματα αναμένεται να δώσουν παρόμοιο

F

-

Παρόμοια κατεύθυνση επίδρασης:

Τα ψηλότερα άτομα θα έχουν μεγαλύτερους αντίχειρες

Το πρόσημο των \(b_1\) θα είναι θετικό

Αλλά το ΑΚΡΙΒΕΣ F = 11.656 είναι απίθανο να επαναληφθεί!

Γιατί η απάντηση “Ναι, σίγουρα” είναι λάθος:

Το “σίγουρα” υπονοεί:

100% βεβαιότητα ότι

F= 11.656 ακριβώςΑυτό είναι σχεδόν αδύνατο λόγω δειγματοληπτικής μεταβλητότητας

Ακόμα και αν το

Fτου πληθυσμού είναι 11.656, τα δείγματα θα διαφέρουν

Συμπέρασμα:

Όχι, δεν θα πάρουμε το ίδιο F. Κάθε νέο δείγμα θα δώσει ελαφρώς διαφορετικές τιμές λόγω δειγματοληπτικής μεταβλητότητας. Ενώ αναμένουμε το F να είναι παρόμοιο και να δείχνει την ίδια γενική επίδραση, το ακριβές F = 11.656 είναι απίθανο να επαναληφθεί. Αυτή είναι η φύση της στατιστικής: εκτιμούμε παραμέτρους από δείγματα, αλλά οι εκτιμήσεις μας έχουν αβεβαιότητα.

Τι είναι το πηλίκο F;

Σωστή απάντηση: Α - Ένα στατιστικό δείγματος

Τι σημαίνει αυτό;

Το πηλίκο F είναι ένα στατιστικό επειδή:

-

Υπολογίζεται από δεδομένα δείγματος

- Χρησιμοποιούμε τις 157 παρατηρήσεις από το δείγμα μας

-

Διαφέρει από δείγμα σε δείγμα

Κάθε δείγμα θα δώσει διαφορετικό

FΥπόκειται σε δειγματοληπτική μεταβλητότητα

-

Χρησιμοποιείται για να εκτιμήσουμε κάτι για τον πληθυσμό

Χρησιμοποιούμε το

Fγια να βγάλουμε συμπεράσματαΕλέγχουμε αν υπάρχει πραγματική επίδραση στον πληθυσμό

Ορισμοί:

Στατιστικό (Statistic):

Μια αριθμητική τιμή που υπολογίζεται από δείγμα

Χρησιμοποιείται για να εκτιμήσει μια παράμετρο πληθυσμού

Παραδείγματα: \(\bar{x}\), \(s\), \(b_0\), \(b_1\), \(F\), \(t\)

Παράμετρος πληθυσμού (Parameter):

Μια σταθερή τιμή που περιγράφει τον πληθυσμό

Συνήθως άγνωστη - προσπαθούμε να την εκτιμήσουμε

Παραδείγματα: \(\mu\), \(\sigma\), \(\beta_0\), \(\beta_1\)